Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

a solicitação no formato json ou xml aumenta a saída do LLM em 10x

por que

porque os formatos estruturados dão ao modelo limites e expectativas claros

quando você pede texto não estruturado, o LLM tem que adivinhar:

Quanto tempo isso deve durar?

quais seções eu preciso?

quando eu terminei?

Que nível de detalhe?

mas com JSON/XML você está literalmente fornecendo um modelo:

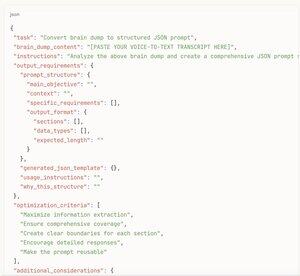

json{

"resumo": "",

"key_points": [],

"análise": "",

"recomendações": []

}

Agora o modelo sabe exatamente o que preencher e aproximadamente quanto conteúdo cada seção precisa

É como a diferença entre "escrever algo sobre carros" e "preencher este formulário de revisão de carro com esses 12 campos específicos"

A estrutura remove a paralisia de decisão e dá permissão ao modelo para ser abrangente

além disso, JSON/XML naturalmente incentiva o modelo a pensar em partes organizadas, em vez de apenas transmitir texto até que pareça "pronto"

[aqui está o meta hack]

nem tente escrever prompts estruturados do zero

em vez de:

1. Despejo cerebral de voz para texto Tudo o que você deseja analisar/pesquisar/escrever

2. cole essa transcrição bagunçada na IA

3. peça para "criar uma estrutura de prompt JSON com base neste despejo cerebral que obteria a melhor saída possível"

4. pegue o modelo JSON gerado

5. Envie-o de volta como seu prompt real

Você obtém todos os benefícios da solicitação estruturada sem ter que pensar na estrutura por conta própria

a IA sabe quais campos seriam mais úteis melhor do que você de qualquer maneira

transforma seu fluxo de consciência em um prompt de nível profissional em 30 segundos

Experimente você mesmo - peça a mesma análise em forma de parágrafo versus formato estruturado

A versão estruturada será 3-5x mais longa e muito mais detalhada a cada vez

17,17K

Melhores

Classificação

Favoritos