Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

het gebruik van prompts in JSON- of XML-formaat verhoogt de output van LLM met 10x

waarom

omdat gestructureerde formaten het model duidelijke grenzen en verwachtingen geven

wanneer je om ongestructureerde tekst vraagt, moet de LLM raden:

hoe lang moet dit zijn?

welke secties heb ik nodig?

wanneer ben ik klaar?

welk detailniveau?

maar met JSON/XML geef je letterlijk een sjabloon:

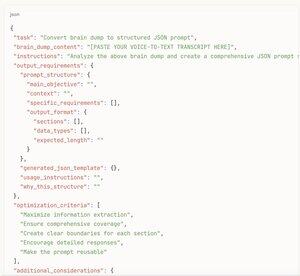

json{

"samenvatting": "",

"kernpunten": [],

"analyse": "",

"aanbevelingen": []

}

nu weet het model precies wat het moet invullen en ongeveer hoeveel inhoud elke sectie nodig heeft

het is als het verschil tussen "schrijf iets over auto's" versus "vul dit autobeoordelingsformulier in met deze 12 specifieke velden"

de structuur verwijdert besluiteloosheid en geeft het model toestemming om uitgebreid te zijn

bovendien moedigt JSON/XML het model van nature aan om in georganiseerde stukken te denken in plaats van gewoon tekst te streamen totdat het zich "klaar" voelt

[hier is de meta-hack]

probeer niet eens gestructureerde prompts vanaf nul te schrijven

in plaats daarvan:

1. spreek alles wat je wilt laten analyseren/onderzoeken/schrijven in tekst om

2. plak die rommelige transcriptie naar de AI

3. vraag het om "een JSON-promptstructuur te maken op basis van deze brain dump die de best mogelijke output zou opleveren"

4. neem dat gegenereerde JSON-sjabloon

5. stuur het terug als je daadwerkelijke prompt

dan krijg je alle voordelen van gestructureerd prompten zonder zelf over de structuur na te denken

de AI weet welke velden het nuttigst zouden zijn beter dan jij

het verandert je stroom van bewustzijn in een professioneel niveau prompt in 30 seconden

probeer het zelf - vraag om dezelfde analyse in paragraafvorm versus gestructureerd formaat

de gestructureerde versie zal elke keer 3-5x langer en veel gedetailleerder zijn.

17,16K

Boven

Positie

Favorieten