Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

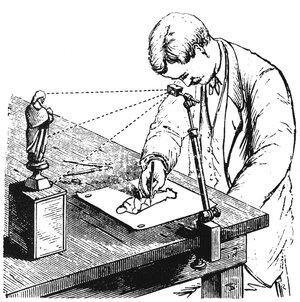

En «camera lucida» er en enhet som bruker et prisme som holdes av et metallanker for å projisere et bilde av scenen foran seg på et stykke papir under det, omtrent som en moderne projektor koblet til en live kamerastrøm.

Disse ble sannsynligvis oppfunnet på begynnelsen av 1400-tallet, selv om publiserte beretninger om dem ikke dukker opp før på slutten av 1500-tallet. Noe av grunnen til det er sannsynligvis at de var nøye bevoktede forretningshemmeligheter til kunstnere som brukte dem for å oppnå en grad av nøyaktighet som tidligere var umulig eller i det minste ekstremt vanskelig å gjøre på en "frihånd" uten hjelp.

Kunstneren David Hockney ble veldig interessert i dette emnet for mange år siden og skrev en bok om det i 2001. Hans grunnleggende teori var at den bemerkelsesverdige forbedringen i nøyaktighet og realisme direkte kunne tilskrives hemmelig bruk av camera lucida (og også en tidligere enhet kalt camera obscura).

Som han påpekte, før den perioden, ville du aldri se et maleri av en lutt i perspektiv som ikke så forvrengt og feil ut. Mens du kunne bruke "perspektivreglene" til å tegne enkle rettlinjede former realistisk, var den mer komplekse geometrien til en lutt utenfor normal menneskelig evne til å skildre realistisk i rommet. Denne teorien er kjent som Hockney-Falco-avhandlingen.

Helt siden jeg lærte om dette på college på begynnelsen av 2000-tallet, brukte jeg på en måte mentalt en stjerne på verkene til visse malere. For eksempel, så mye som jeg respekterer og beundrer Ingres og Caravaggio, ble ærefrykten jeg hadde for ferdighetene deres dempet av erkjennelsen av at de sannsynligvis benyttet seg av denne typen mekanisk hjelp.

Og jada, mye av kunstnerskapet ligger i konseptet, komposisjonen og innrammingen, fargene, malingsstrøkene osv. Men den fantastiske naturtro realismen er det som imponerte meg mest, og den delen av den ble i det minste delvis knust av denne avsløringen. Det fikk meg også til å respektere den skulpturelle realismen til Michelangelo enda mer (og også hans studier som helt klart er skisser laget av livet).

Uansett, grunnen til at jeg tar opp dette nå er at jeg tror vi er på randen av at den samme typen ting skjer innen matematiske forskningsfelt med bruken av modeller som GPT-5 Pro.

Jeg har allerede brukt den til å gjøre det jeg mistenker er genuint ny og interessant forskning (som jeg har beskrevet i nylige tråder), og vi fikk i dag en oppdatering fra Sebastien Bubeck hos OpenAI som viste at modellen var i stand til å bevise et interessant resultat i moderne matematikk ved hjelp av et nytt bevis, i et enkelt skudd ikke mindre.

Så denne nye tidsalderen er plutselig over oss. Vi så nettopp et resultat fra kinesiske informatikere forrige uke som slo en rekord for optimal sortering som sto i 45 år.

Jeg tenkte den gangen på hvordan jeg lurte på om AI ble brukt på en eller annen måte for å generere det resultatet.

Se også den nylige artikkelen i den siterte tweeten, som har en lignende karakter ved at den er både overraskende og likevel elementær. Dette ser ut til å være kjennetegn på resultater som kan ha dratt nytte av AI på en eller annen måte.

Nå vil jeg ikke anklage disse forfatterne for noe. For alt jeg vet gjorde de alt manuelt, akkurat som malerne på 1300-tallet gjorde.

Og selv om de brukte AI for å hjelpe dem, har vi ennå ikke akseptert skikker om hvordan vi skal håndtere det: hvilke avsløringer som er berettiget, og hvordan kreditt skal fordeles og vurderes. Hele konseptet med forfatterskap må revurderes i dag.

I min siste tråd der jeg undersøkte sammen med GPT-5 Pro om bruken av Lie-teori i dyp læring, utviklet jeg spørsmålene selv, selv om jeg aldri på en million år ville være i stand til å generere teorien og koden som modellen utviklet som et resultat av disse spørsmålene. Får jeg æren for resultatet hvis det viser seg å revolusjonere feltet?

Hva med det påfølgende eksperimentet mitt, hvor jeg brukte de originale spørsmålene mine som jeg skrev selv sammen med en "meta-ledetekst" for å få GPT-5 Pro til å komme opp med 10 flere par ledetekster modellert løst etter min egen, men som involverte helt forskjellige grener av matematikk som utviklet seg i helt forskjellige retninger.

Får jeg kreditt for disse teoriene hvis de viser seg å være viktige? Jeg håper virkelig det, fordi jeg allerede har publisert ideene og koden på GitHub og publisert dem bredt, så hvis noen følger opp disse undersøkelseslinjene, vil akademisk etikk kreve at de siterer meg.

Men selv om du synes jeg fortjener ros for å styre AI-en med min egen ledetekst, så er sikkert påstandene mine om prioritet noe svekket for de 10 andre teoriene som er resultatet av å bruke forespørselen min som en modell for meta-forespørsel, ikke sant? Tross alt visste jeg ikke engang at "tropisk geometri" var en ting for et par dager siden, men nå har jeg en teori og kode som bruker den på AI-forskning.

Jeg vil påstå at akkurat da jeg mentalt begynte å bruke en stjerne på visse kunstverk og kunstnere som ligner på stjernen ved siden av Barry Bonds navn i Hall of Fame, mistenker jeg at de fleste forskere vil begynne å gjøre det samme for alle nye matematiske teoribaserte artikler i løpet av det neste året eller så.

Jeg mistenker at folk snart nok vil si ting som "denne fyren er ekte vare; han skrev sine beste artikler før 2025!" for å skille mellom de som gjorde alt arbeidet sitt manuelt ved å bruke sin egen hjerne kontra de som brukte AI-assistanse.

Og det er absolutt en gyldig måte å tenke på ting på hvis AI ikke bare er i stand til å svare på vanskelige teoretiske problemer, men til og med stille de interessante spørsmålene på egen hånd.

Hvis jeg har rett, bør vi forberede oss på en kommende tsunami av sjokkerende forskningsartikler som slår langvarige rekorder og grenser, og knuser gjennom vegger som lenge ble antatt å være relativt ugjennomtrengelige uten en eller annen gjennombruddsteori.

Og jeg tror mange av disse resultatene vil ha noe til felles: at de alltid var der foran oss, men krevde å kombinere teori fra forskjellige områder av matematikk og anvendte på nye måter som ikke ble forfulgt før på grunn av menneskelige, sosiologiske årsaker: forskjellige felt som deler seg på tvers av linjer, med forskjellig terminologi, tidsskrifter, praksiser, avdelinger, konferanser, sosiale nettverk osv.

Den andre formen jeg mistenker at disse resultatene vil ta, er å utnytte elementære resultater på bisarre måter som, av en eller annen grunn, ikke kommer naturlig for menneskelige hjerner, men som vi kan forstå når de er tydelig forklart for oss.

En annen form de kan ta er resultater som utnytter for lengst glemt esoterika fra sen 19-tallsanalyse. Den typen triks som tillot Feynman å løse integraler som ingen andre kunne løse.

Disse resultatene er kjent og eksisterer i bøker, men ingen leser disse bøkene lenger, og de opprinnelige teoriene de ble utviklet for har i stor grad blitt erstattet av vårt moderne maskineri som opererer på mange nivåer av økt abstraksjon og generalitet.

En annen form de kan ta er ganske enkelt å bruke kjent matematikk som forstås av bare noen få hundre spesialiserte genier i verden som bare fokuserer på teori og ikke i det hele tatt på applikasjoner.

Dette regnestykket kan bare ha "sittet rundt" siden 1950- eller 1970-tallet og ventet på at noen skulle bruke det på et praktisk problem som de i AI-forskning. Mange av ideene jeg undersøkte med GPT-5 ser ut til å falle inn i denne kategorien.

20. aug., 20:43

Holy shit de fant en potensserieløsning til ALLE polynomligninger!! (omgå Galois som sier at du ikke kan løse dem i radikaler)

50,66K

Topp

Rangering

Favoritter