Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

Syyskuun 4. päivänä klo 17-21 PDT Berkeleyssä Hamel Husain johtaa keskustelua, jossa Claire Vo, Greg Ceccarelli ja minä puhumme siitä, miten Mihaly Csikszentmihalyin flow-tila saavutetaan tekoälyn avulla.

@HamelHusain on koneoppimisinsinööri, jolla on yli 20 vuoden kokemus. Hän on työskennellyt Airbnb:n ja GitHubin kaltaisten yritysten kanssa, jotka sisälsivät OpenAI:n koodin ymmärtämiseen käyttämän varhaisen LLM-tutkimuksen. Hän on myös johtanut ja osallistunut lukuisiin suosittuihin avoimen lähdekoodin koneoppimistyökaluihin ja on tällä hetkellä riippumaton konsultti, joka auttaa yrityksiä rakentamaan tekoälytuotteita.

@clairevo on ChatPRD:n perustaja ja "How I AI" -podcastin isäntä. 3x:n tuote- ja teknologiajohtajana hän on johtanut skaalautuneita tuote- ja suunnittelutiimejä yrityksissä, kuten LaunchDarkly, Color Health ja Optimizely. Hänet tunnetaan tekoälyagenttien käyttämisestä ominaisuuksien rakentamiseen päästä päähän, ja hän on luonut kuusinumeroisen tekoälyllä toimivan sivuprojektin johtaessaan LaunchDarklyn tuote- ja suunnitteluorganisaatioita.

@gregce10 on SpecStoryn perustaja ja CPO. Aiemmin hän johti tuotetta Pluralsightissa ja johti datatiedettä GitHubissa, aiemmin Googlella ja Dropboxilla. Hänen kokeilunsa ovat laajoja ja kauaskantoisia, minituotteiden toimittamisesta korkealaatuisten tuotemarkkinointivideoiden luomiseen tekoälyn avulla sekä hänen päivätyöhönsä SpecStoryn rakentamisessa.

Jos olet utelias tekoälyn virtaustilasta, rekisteröidy täällä:

6,79K

Multimodaalinen on datan tulevaisuus

changhiskhan22.8. klo 02.52

Olen ollut Netflixin insinööriblogin suuri fani jo pitkään. Niin innoissani siitä, että @lancedb on tärkeä osa multimodaalista tekoälyn muutosta tietotekniikassa

2,96K

GPT-5 saavuttaa 94,6 %:n tarkkuuden AIME 2025:ssä, mikä viittaa lähes inhimilliseen matemaattiseen päättelyyn.

Pyydä sitä tekemään kysely tietokannastasi, ja onnistumisprosentit putoavat teini-ikäisiin.

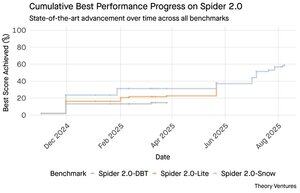

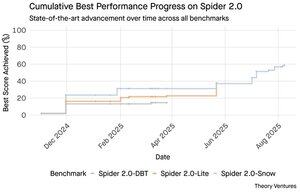

Spider 2.0:n vertailuarvot paljastavat ammottavan aukon tekoälyn ominaisuuksissa. Spider 2.0 on kattava tekstistä SQL:ksi -vertailuarvo, joka testaa tekoälymallien kykyä luoda tarkkoja SQL-kyselyitä luonnollisen kielen kysymyksistä todellisissa tietokannoissa.

Vaikka suuret kielimallit ovat valloittaneet matematiikan, koodauksen ja päättelyn tietotyön, tekstistä SQL:ksi on edelleen sitkeän vaikeaa.

Kolme Spider 2.0 -vertailuarvoa testaavat todellisia tietokantakyselyjä eri ympäristöissä. Spider 2.0-Snow käyttää Snowflake-tietokantoja, joissa on 547 testiesimerkkiä, ja sen tarkkuus on 59,05 %.

Spider 2.0-Lite kattaa BigQueryn, Snowflaken ja SQLiten 547 muulla esimerkillä, saavuttaen vain 37,84 %. Spider 2.0-DBT testaa koodin luomista DuckDB:tä vastaan 68 esimerkillä, ja huippu on 39,71 %.

Tämä suorituskykyero ei johdu yrittämisen puutteesta. Marraskuusta 2024 lähtien 56 ehdotusta 12 malliperheestä on kilpaillut näillä vertailuarvoilla.

Claude, OpenAI, DeepSeek ja muut ovat kaikki työntäneet mallejaan näitä testejä vastaan. Kehitys on ollut tasaista, noin 2 prosentista noin 60 prosenttiin viimeisen yhdeksän kuukauden aikana.

Palapeli syvenee, kun otetaan huomioon SQL:n rajoitukset. SQL:llä on rajallinen sanavarasto verrattuna englantiin, jossa on 600 000 sanaa, tai ohjelmointikieliin, joissa on paljon laajemmat syntaksit ja kirjastot. Lisäksi siellä on paljon SQL:ää, jolla voit harjoitella.

Jos jotain, tämän pitäisi olla helpompaa kuin avoimet päättelytehtävät, joissa mallit ovat nyt erinomaisia.

Edes täydellinen SQL-generointi ei kuitenkaan ratkaisisi todellista liiketoimintahaastetta. Jokainen yritys määrittelee "tulot" eri tavalla.

Markkinointi mittaa asiakashankintakustannuksia kampanjakulujen mukaan, myynti laskee sen asiakkuuskulujen perusteella ja talous sisältää täyteen ladatut henkilöstökulut. Nämä semanttiset erot aiheuttavat hämmennystä, jota tekninen tarkkuus ei pysty ratkaisemaan.

Spider 2.0:n tulokset viittaavat perustavanlaatuiseen totuuteen datatyöstä. SQL-syntaksin tekninen taito on vain lähtökohta.

Todellinen haaste on liiketoimintakontekstissa. Ymmärtää, mitä tiedot tarkoittavat, miten eri tiimit määrittelevät mittarit ja milloin reunatapauksilla on merkitystä. Kuten kirjoitin Semantic Cultivators -kirjassani, silta raakadatan ja liiketoiminnan merkityksen välillä vaatii ihmisen harkintaa, jota nykyinen tekoäly ei pysty toistamaan.

9,53K

GPT-5 saavuttaa 94,6 %:n tarkkuuden AIME 2025:ssä, mikä viittaa lähes inhimilliseen matemaattiseen päättelyyn.

Pyydä sitä tekemään kysely tietokannastasi, ja onnistumisprosentit putoavat teini-ikäisiin.

Spider 2.0:n vertailuarvot paljastavat ammottavan aukon tekoälyn ominaisuuksissa. Spider 2.0 on kattava tekstistä SQL:ksi -vertailuarvo, joka testaa tekoälymallien kykyä luoda tarkkoja SQL-kyselyitä luonnollisen kielen kysymyksistä todellisissa tietokannoissa.

Vaikka suuret kielimallit ovat valloittaneet matematiikan, koodauksen ja päättelyn tietotyön, tekstistä SQL:ksi on edelleen sitkeän vaikeaa.

Kolme Spider 2.0 -vertailuarvoa testaavat todellisia tietokantakyselyjä eri ympäristöissä. Spider 2.0-Snow käyttää Snowflake-tietokantoja, joissa on 547 testiesimerkkiä, ja sen tarkkuus on 59,05 %.

Spider 2.0-Lite kattaa BigQueryn, Snowflaken ja SQLiten 547 muulla esimerkillä, saavuttaen vain 37,84 %. Spider 2.0-DBT testaa koodin luomista DuckDB:tä vastaan 68 esimerkillä, ja huippu on 39,71 %.

Tämä suorituskykyero ei johdu yrittämisen puutteesta. Marraskuusta 2024 lähtien 56 ehdotusta 12 malliperheestä on kilpaillut näillä vertailuarvoilla.

Claude, OpenAI, DeepSeek ja muut ovat kaikki työntäneet mallejaan näitä testejä vastaan. Kehitys on ollut tasaista, noin 2 prosentista noin 60 prosenttiin viimeisen yhdeksän kuukauden aikana.

Palapeli syvenee, kun otetaan huomioon SQL:n rajoitukset. SQL:llä on rajallinen sanavarasto verrattuna englantiin, jossa on 600 000 sanaa, tai ohjelmointikieliin, joissa on paljon laajemmat syntaksit ja kirjastot. Lisäksi siellä on paljon SQL:ää, jolla voit harjoitella.

Jos jotain, tämän pitäisi olla helpompaa kuin avoimet päättelytehtävät, joissa mallit ovat nyt erinomaisia.

Edes täydellinen SQL-generointi ei kuitenkaan ratkaisisi todellista liiketoimintahaastetta. Jokainen yritys määrittelee "tulot" eri tavalla.

Markkinointi mittaa asiakashankintakustannuksia kampanjakulujen mukaan, myynti laskee sen asiakkuuskulujen perusteella ja talous sisältää täyteen ladatut henkilöstökulut. Nämä semanttiset erot aiheuttavat hämmennystä, jota tekninen tarkkuus ei pysty ratkaisemaan.

Spider 2.0:n tulokset viittaavat perustavanlaatuiseen totuuteen datatyöstä. SQL-syntaksin tekninen taito on vain lähtökohta.

Todellinen haaste on liiketoimintakontekstissa. Ymmärtää, mitä tiedot tarkoittavat, miten eri tiimit määrittelevät mittarit ja milloin reunatapauksilla on merkitystä. Kuten kirjoitin Semantic Cultivators -kirjassani, silta raakadatan ja liiketoiminnan merkityksen välillä vaatii ihmisen harkintaa, jota nykyinen tekoäly ei pysty toistamaan.

4,25K

Perplexity AI teki juuri 34,5 miljardin dollarin ei-toivotun tarjouksen Googlen Chrome-selaimesta yrittäen hyödyntää vireillä olevaa kilpailupäätöstä, joka voi pakottaa Googlen luopumaan selainliiketoiminnastaan.

Chromen talouden vertaaminen Googlen nykyiseen Safari-sopimukseen paljastaa, miksi 34,5 miljardia dollaria aliarvioi selaimen.

Google maksaa Applelle vuosittain 18–20 miljardia dollaria pysyäkseen Safarin oletushakukoneena¹, joka palvelee noin 850 miljoonaa käyttäjää². Tämä tarkoittaa 21 dollaria käyttäjää kohden vuodessa.

Perplexity-tarjouksen arvo on Chromen arvo 32 miljardia dollaria, mikä on 9 dollaria käyttäjää kohden vuodessa sen 3,5 miljardille käyttäjälle³.

Jos Chromen käyttäjät noudattaisivat samoja ehtoja kuin Google/Apple Safari -sopimus, selaimen vuotuinen tulopotentiaali ylittäisi 73 miljardia dollaria.

Nämä tiedot perustuvat julkisiin arvioihin, mutta ovat likimääräisiä.

Tämä olettaa, että Google maksaisi Chromen uudelle omistajalle samanlaisen skaalatun maksun oletushakusijoittelusta. Kun otetaan huomioon 5x–6x markkina-arvo ja tulojen kerroin, Chromen arvo on jossain 172–630 miljardia dollaria, mikä on kaukana 34,5 miljardin dollarin tarjouksesta.

Chrome hallitsee markkinoita 65 prosentin osuudella⁴ verrattuna Safarin 18 prosenttiin. Myynti aiheuttaisi hakumainosmarkkinat mullistukseen. Mainostajien budjettien säilyttämisen arvoa on vaikea yliarvioida Googlen markkina-arvolle ja asemalle mainosekosysteemissä.

Jos Google joutuisi myymään Chromen, se joutuisi eksistentiaalisen valinnan eteen. Maksa mitä tahansa pysyäksesi oletushakukoneena tai katso, kuinka kilpailijat muuttavat sen arvokkaimman jakelukanavan sitä vastaan.

Kuinka paljon se on arvoinen? Merkittävä preemio yksinkertaiseen tulokertoimeen.

¹ Bloomberg: Googlen maksut Applelle nousivat 20 miljardiin dollariin vuonna 2022 (

² ZipDo: Olennaiset Apple Safari -tilastot vuonna 2024 (

³ Backlinko: Verkkoselaimen markkinaosuus vuonna 2025 (

⁴ Statcounter: Selaimen markkinaosuus maailmanlaajuisesti (

8,14K

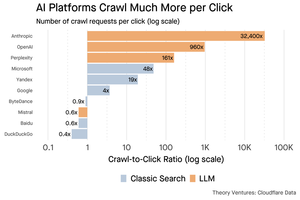

Vuonna 1999 dotcomeja arvostettiin liikenteen perusteella. Listautumisannin mittarit pyörivät silmämunien ympärillä.

Sitten Google lanseerasi AdWordsin, klikkauksiin perustuvan mainosmallin, ja rakensi 273 miljardin dollarin liiketoiminnan vuonna 2024.

Mutta tämä kaikki saattaa olla muuttumassa: Pew Researchin heinäkuussa 2025 tekemä tutkimuspaljastaa, että käyttäjät napsauttavat vain 8 prosenttia hakutuloksista tekoälytiivistelmien kanssa, kun taas 15 prosenttia ilman sitä - 47 prosentin vähennys. Vain 1 % napsauttaa läpi tekoälyn yhteenvedoista.

Cloudflare-tiedot osoittavat, että tekoälyalustat indeksoivat sisältöä paljon enemmän kuin ohjaavat liikennettä takaisin: Anthropic indeksoi 32 400 sivua jokaista viittausta kohden, kun taas perinteiset hakukoneet skannaavat sisältöä vain pari kertaa lähetettyä kävijää kohden.

Sisällön tarjoaminen tekoälyn indeksoijille ei välttämättä ole valtavaa, jos se on enimmäkseen tekstiä.

Suurempi pointti on se, että tekoälyjärjestelmät erottavat käyttäjän ja julkaisijan suhteen. Käyttäjät suosivat koottuja tekoälyvastauksia sen sijaan, että klikkaisivat verkkosivustoja löytääkseen vastauksensa.

On loogista, että useimpien verkkosivustojen pitäisi odottaa vähemmän liikennettä. Miten verkkosivustosi ja yrityksesi hoitavat sen?

Lähteistä:

- Pew Research Center - Athena Chapekis, 22. heinäkuuta 2025 (

- Cloudflare: Indeksointi ennen viittausten putoamista (

- Cloudflare-tutka: AI Insights - Indeksoinnin ja viittauksen suhde (

- Podcast: Sisällön muuttuva arvo tekoälyn aikakaudella (

9,81K

GPT-5 julkaistiin eilen. 94,6 % AIME 2025:ssä. 74,9 % SWE-penkillä.

Kun lähestymme näiden vertailuarvojen ylärajoja, ne kuolevat.

Se, mikä tekee GPT-5:stä ja seuraavan sukupolven malleista vallankumouksellisia, ei ole heidän tietonsa. Se on sitä, että tietää, miten toimia. GPT-5:ssä tämä tapahtuu kahdella tasolla. Ensin on päätettävä, mitä mallia käytät. Mutta toiseksi, ja mikä tärkeintä, työkalukutsun kautta.

Olemme eläneet aikakautta, jolloin LLM-opiskelijat hallitsivat tiedonhaun ja kokoamisen. Kuluttajien haku ja koodaus, ensimmäiset tappavat sovellukset, ovat pohjimmiltaan tiedonhaun haasteita. Molemmat järjestävät olemassa olevaa tietoa uusilla tavoilla.

Olemme kiivenneet noita mäkiä, ja sen seurauksena kilpailu on kovempaa kuin koskaan. Anthropicin, OpenAI:n ja Googlen mallit lähentyvät samanlaisia ominaisuuksia. Kiinalaiset mallit ja avoimen lähdekoodin vaihtoehdot työntyvät yhä lähemmäs huippua. Jokainen voi hakea tietoa. Jokainen voi luoda tekstiä.

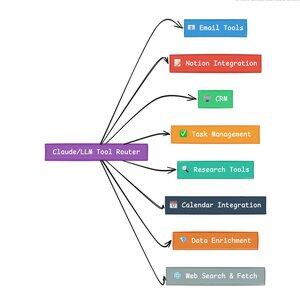

Uusi kilpailuakseli? Työkalujen kutsuminen.

Työkalukutsu muuttaa LLM:t neuvonantajista toimijoiksi. Se kompensoi kahta kriittistä mallin heikkoutta, joita puhtaat kielimallit eivät pysty voittamaan.

Ensinnäkin työnkulun orkestrointi. Mallit ovat erinomaisia yhden laukauksen vasteissa, mutta kamppailevat monivaiheisten, tilallisten prosessien kanssa. Työkalujen avulla he voivat hallita pitkiä työnkulkuja, seurata edistymistä, käsitellä virheitä ja ylläpitää kontekstia kymmenissä toiminnoissa.

Toinen on järjestelmän integrointi. LLM:t elävät vain tekstiä sisältävässä maailmassa. Työkalujen avulla ne voivat olla ennustettavasti yhteydessä ulkoisiin järjestelmiin, kuten tietokantoihin, ohjelmointirajapintoihin ja yritysohjelmistoihin, ja muuttaa luonnollisen kielen suoritettaviksi toiminnoiksi.

Viimeisen kuukauden aikana olen rakentanut 58 erilaista tekoälytyökalua.

Sähköpostin käsittelijät. CRM-integraattorit. Käsitteen päivittäjät. Tutkimusavustajat. Jokainen työkalu laajentaa mallin ominaisuuksia uudelle alueelle.

Tekoälyn tärkein ominaisuus on oikean työkalun valinta nopeasti ja oikein. Jokainen väärin reititetty vaihe tappaa koko työnkulun.

Kun sanon "lue tämä Y Combinatorin sähköposti ja etsi kaikki startup-yritykset, jotka eivät ole CRM:ssä", nykyaikaiset LLM:t suorittavat monimutkaisen sarjan.

Yksi englanninkielinen komento korvaa koko työnkulun. Ja tämä on vain yksinkertainen.

Mikä parasta, oikein asetettu malli oikeilla työkaluilla voi varmistaa oman työnsä, että tehtävät on suoritettu ajallaan. Tämä itsevarmistussilmukka luo työnkulkuihin luotettavuutta, jota on vaikea saavuttaa muuten.

Kerro tämä satojen työntekijöiden kesken. Tuhansia työnkulkuja. Tuottavuuden kasvu kasvaa eksponentiaalisesti.

Tulevaisuuden tekoälymaailman voittajia ovat ne, jotka ovat kehittyneimpiä työkalujen orkestroinnissa ja oikeiden kyselyiden reitittämisessä. Joka kerta. Kun nämä työnkulut ovat ennustettavissa, meistä kaikista tulee agenttipäälliköitä.

3,28K

Vuosi 2025 on agenttien vuosi, ja agenttien avainominaisuus on soittotyökalut.

Claude Codea käytettäessä voin käskeä tekoälyä seulomaan uutiskirjeen, etsimään kaikki linkit startup-yrityksiin ja varmistamaan niiden olemassaolon CRM:ssämme yhdellä komennolla. Tämä voi tarkoittaa kahden tai kolmen eri työkalun kutsumista.

Mutta tässä on ongelma: suuren perustusmallin käyttäminen tähän on kallista, usein rajoitettua ja ylivoimaista valintatehtävään.

Mikä on paras tapa rakentaa agenttijärjestelmä työkalukutsulla?

Vastaus löytyy pienistä toimintamalleista. NVIDIA julkaisi vakuuttavan paperin, jossa väitettiin, että "Pienet kielimallit (SLM) ovat riittävän tehokkaita, luonnostaan sopivampia ja välttämättä taloudellisempia monille kutsuille agenttijärjestelmissä."

Olen testannut erilaisia paikallisia malleja kustannusten vähentämisen vahvistamiseksi. Aloitin Qwen3:30b-parametrimallilla, joka toimii, mutta voi olla melko hidas, koska se on niin suuri malli, vaikka vain 3 miljardia noista 30 miljardista parametrista on aktiivisia kerrallaan.

NVIDIAn paperi suosittelee Salesforce xLAM -mallia – erilaista arkkitehtuuria, jota kutsutaan suureksi toimintamalliksi, joka on suunniteltu erityisesti työkalujen valintaan.

Joten tein oman testin, jossa jokainen malli kutsui työkalua Asana-tehtävieni luettelemiseksi.

Tulokset olivat silmiinpistäviä: xLAM suoritti tehtävät 2,61 sekunnissa 100 %:n onnistumisella, kun taas Qwen kesti 9,82 sekuntia 92 %:n onnistumisella – lähes neljä kertaa kauemmin.

Tämä koe osoittaa nopeuden kasvun, mutta siinä on kompromissi: kuinka paljon älykkyyttä mallissa pitäisi elää verrattuna itse työkaluihin. Tämä rajoitettu

Suuremmissa malleissa, kuten Qwenissä, työkalut voivat olla yksinkertaisempia, koska mallilla on parempi virhetoleranssi ja se voi kiertää huonosti suunniteltuja käyttöliittymiä. Malli kompensoi työkalujen rajoituksia raa'an voiman päättelyn avulla.

Pienemmissä malleissa mallilla on vähemmän kykyä toipua virheistä, joten työkalujen on oltava kestävämpiä ja valintalogiikan tarkempia. Tämä saattaa tuntua rajoitukselta, mutta se on itse asiassa ominaisuus.

Tämä rajoitus eliminoi LLM-ketjutettujen työkalujen yhdistelmävirheprosentin. Kun suuret mallit tekevät peräkkäisiä työkalukutsuja, virheet kasaantuvat eksponentiaalisesti.

Pienet toimintamallit pakottavat parempaan järjestelmäsuunnitteluun, säilyttämällä LLM:n parhaat puolet ja yhdistämällä ne erikoismalleihin.

Tämä arkkitehtuuri on tehokkaampi, nopeampi ja ennustettavampi.

5,4K

Johtavat

Rankkaus

Suosikit

Ketjussa trendaava

Trendaa X:ssä

Viimeisimmät suosituimmat rahoitukset

Merkittävin