Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

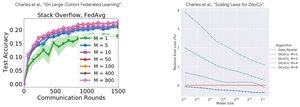

Phân tích hiệu suất: DiLoCo so với Học tập phân tán

Phát hiện ngược đời: Hiệu suất của DiLoCo trở nên TỆ HƠN với nhiều bản sao hơn (M↑ = hiệu suất↓), trong khi Học tập phân tán trở nên TỐT HƠN với nhiều khách hàng hơn (M↑ = hiệu suất↑)

Tại sao lại có xu hướng ngược lại?

DiLoCo: Ngân sách dữ liệu cố định chia thành M phần. Nhiều bản sao = Ít dữ liệu hơn cho mỗi bản sao. Do đó, tổng tính toán vẫn không đổi (phân tích isoflop) và mỗi công nhân thấy D/M dữ liệu = học kém hơn

Học tập phân tán: Mỗi khách hàng mang đến DỮ LIỆU MỚI. Nhiều khách hàng = Nhiều tập dữ liệu độc đáo tổng cộng. Mỗi khách hàng thêm cả tính toán VÀ dữ liệu mới. Do đó, tổng dữ liệu tăng lên: D₁ + D₂ + ... + Dₘ = học tốt hơn

Thông tin chính: Không phải là về thuật toán - mà là về các ràng buộc tài nguyên!

Cảm ơn bài nói chuyện đầy ánh sáng của @MatharyCharles trong Scratch to Scale, tôi đã học được rất nhiều về DiLoCo và Học tập phân tán.

Nếu bạn quan tâm đến việc tìm hiểu thêm về DiLoCo, đào tạo và suy diễn phân tán và tính song song, hãy xem lớp Scratch to Scale của @TheZachMueller hoặc bất kỳ tài nguyên nào dưới đây:

Nguồn:

DiLoCo:

Học tập phân tán:

Scratch to Scale:

#MachineLearning #DistributedTraining #AI

Hàng đầu

Thứ hạng

Yêu thích