Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

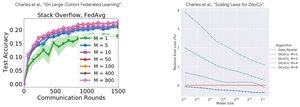

Analýza výkonu: DiLoCo vs federované učení

Neintuitivní zjištění: Výkon DiLoCo se zhoršuje s více replikami (M↑ = výkon ↓), zatímco federované učení se zlepšuje s více klienty (M↑ = výkon ↑)

Proč opačné trendy?

DiLoCo: Pevný datový rozpočet rozdělený M způsoby. Více replik = méně dat na repliku. Celkové výpočetní prostředky tedy zůstávají konstantní (izoflop analýza) a každý pracovník vidí D/M data = horší učení

Federované učení: Každý klient přináší NOVÁ data. Více klientů = více celkových unikátních datových sad. Každý klient přidává výpočetní i aktuální data. Rostou tedy celková data: D₁ + D₂ + ... + Dm = lepší učení

Klíčový poznatek: Není to o algoritmu - je to o omezeních zdrojů!

Díky poučné přednášce o @MatharyCharles ve Scratch to Scale jsem se hodně naučil o DiLoCo a Federated Learning.

Pokud máte zájem dozvědět se více o DiLoCo, distribuovaném trénování a odvozování a paralelismu, podívejte se na kurz Scratch to Scale od @TheZachMueller nebo na některý z těchto zdrojů níže:

Zdroje:

DiLoCo:

Federované učení:

Scratch to Scale:

#MachineLearning #DistributedTraining #AI

Top

Hodnocení

Oblíbené