Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

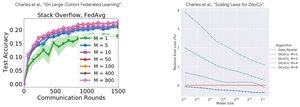

Analiza wydajności: DiLoCo vs Uczenie Federacyjne

Zaskakujące odkrycie: wydajność DiLoCo pogarsza się przy większej liczbie replik (M↑ = wydajność↓), podczas gdy Uczenie Federacyjne poprawia się przy większej liczbie klientów (M↑ = wydajność↑)

Dlaczego przeciwne trendy?

DiLoCo: Stały budżet danych podzielony na M sposobów. Więcej replik = mniej danych na replikę. W związku z tym całkowita moc obliczeniowa pozostaje stała (analiza isoflop) i każdy pracownik widzi D/M danych = gorsze uczenie

Uczenie Federacyjne: Każdy klient wnosi NOWE dane. Więcej klientów = więcej unikalnych zbiorów danych. Każdy klient dodaje zarówno moc obliczeniową, jak i świeże dane. W związku z tym całkowita ilość danych rośnie: D₁ + D₂ + ... + Dₘ = lepsze uczenie

Kluczowy wniosek: To nie kwestia algorytmu - to kwestia ograniczeń zasobów!

Dzięki pouczającemu wykładowi @MatharyCharles w Scratch to Scale, wiele się nauczyłem o DiLoCo i Uczeniu Federacyjnym.

Jeśli chcesz dowiedzieć się więcej o DiLoCo, uczeniu rozproszonym i wnioskowaniu oraz równoległości, sprawdź klasę Scratch to Scale @TheZachMueller lub któreś z poniższych źródeł:

Źródła:

DiLoCo:

Uczenie Federacyjne:

Scratch to Scale:

#MachineLearning #DistributedTraining #AI

Najlepsze

Ranking

Ulubione