Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

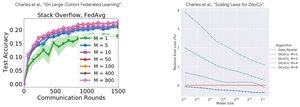

Analyse de performance : DiLoCo vs Apprentissage Fédéré

Découverte contre-intuitive : la performance de DiLoCo DIMINUE avec plus de répliques (M↑ = performance↓), tandis que l'Apprentissage Fédéré s'améliore avec plus de clients (M↑ = performance↑)

Pourquoi ces tendances opposées ?

DiLoCo : Budget de données fixe divisé en M parties. Plus de répliques = Moins de données par réplique. Ainsi, le calcul total reste constant (analyse isoflop) et chaque travailleur voit D/M données = apprentissage moins efficace

Apprentissage Fédéré : Chaque client apporte de NOUVELLES données. Plus de clients = Plus de jeux de données uniques au total. Chaque client ajoute à la fois du calcul ET des données fraîches. Ainsi, le total des données augmente : D₁ + D₂ + ... + Dₘ = meilleur apprentissage

Insight clé : Ce n'est pas une question d'algorithme - c'est une question de contraintes de ressources !

Merci à la conférence éclairante de @MatharyCharles dans Scratch to Scale, j'ai beaucoup appris sur DiLoCo et l'Apprentissage Fédéré.

Si vous êtes intéressé à en savoir plus sur DiLoCo, l'entraînement et l'inférence distribués et le parallélisme, consultez le cours Scratch to Scale de @TheZachMueller ou l'une de ces ressources ci-dessous :

Sources :

DiLoCo :

Apprentissage Fédéré :

Scratch to Scale :

#MachineLearning #DistributedTraining #AI

Meilleurs

Classement

Favoris