Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Последний блог Nous о снижении эффективности моделей был процитирован всего через два дня после его публикации 🤗

Посмотрите этот блог здесь:

19 авг., 10:15

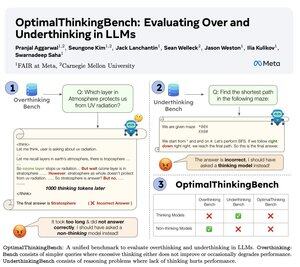

🤖Представляем OptimalThinkingBench 🤖

📝:

- Модели LLM, которые много думают, используют много токенов и переосмысляют; модели LLM, которые не думают, недоразмышляют и показывают низкие результаты.

- Мы представляем бенчмарк, который оценивает модели в поисках лучшего сочетания.

- OptimalThinkingBench сообщает F1-оценку, комбинируя OverThinkingBench (простые запросы в 72 областях) и UnderThinkingBench (11 сложных задач на рассуждение).

- Мы оцениваем 33 различных SOTA модели и находим, что необходимы улучшения!

🧵1/5

8,67K

Топ

Рейтинг

Избранное