Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

El último blog de Nous sobre la eficiencia del adelgazamiento en todos los modelos fue citado solo dos días después de su publicación 🤗

Echa un vistazo a ese blog aquí:

19 ago, 10:15

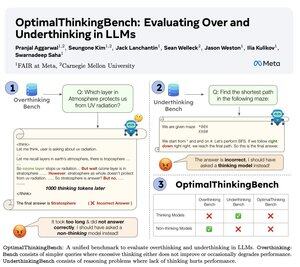

🤖Presentamos OptimalThinkingBench 🤖

📝:

- Los LLM pensantes usan muchos tokens y piensan demasiado; los LLM no pensantes piensan mal y rinden por debajo.

- Presentamos un punto de referencia que puntúa a los modelos en la búsqueda de la mejor combinación.

- OptimalThinkingBench informa la puntuación F1 mezclando OverThinkingBench (consultas simples en 72 dominios) y UnderThinkingBench (11 tareas de razonamiento desafiantes).

- ¡Evaluamos 33 modelos SOTA diferentes y encontramos que se necesitan mejoras!

🧵1/5

8.65K

Populares

Ranking

Favoritas