Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nousův nejnovější blog o efektivitě ztenčování napříč modely byl citován pouhé dva dny po jeho zveřejnění 🤗

Podívejte se na tento blog zde:

19. 8. 10:15

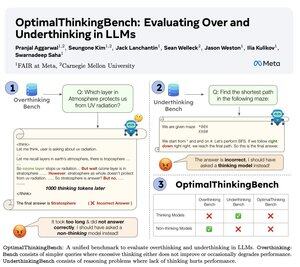

🤖Představujeme OptimalThinkingBench 🤖

📝:

- Myslící LLM využívají hodně tokenů a přemýšlení; nemyslící LLM nedostatečně přemýšlejí a nedostatečně vystupují.

- Zavádíme benchmark, který hodnotí modely při hledání nejlepšího mixu.

- OptimalThinkingBench hlásí F1 skóre kombinující OverThinkingBench (jednoduché dotazy v 72 doménách) a UnderThinkingBench (11 náročných úloh na uvažování).

- Hodnotíme 33 různých modelů SOTA a hledáme potřebná vylepšení!

🧵1/5

8,65K

Top

Hodnocení

Oblíbené