Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Blog terbaru Nous tentang efisiensi penipisan di seluruh model dikutip hanya dua hari setelah diposting 🤗

Periksa blog itu di sini:

19 Agu, 10.15

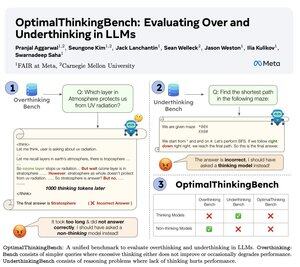

🤖Memperkenalkan OptimalThinkingBench 🤖

📝:

- Berpikir LLM menggunakan banyak token & terlalu banyak berpikir; LLM yang tidak berpikir kurang berpikir & berkinerja buruk.

- Kami memperkenalkan tolok ukur yang menilai model dalam upaya menemukan campuran terbaik.

- OptimalThinkingBench melaporkan skor F1 yang mencampur OverThinkingBench (kueri sederhana dalam 72 domain) & UnderThinkingBench (11 tugas penalaran yang menantang).

- Kami mengevaluasi 33 model SOTA yang berbeda & menemukan perbaikan yang diperlukan!

🧵1/5

8,65K

Teratas

Peringkat

Favorit