Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

.@trailofbits' Buttercup-teamet snakker om konkurransestrategien vår nå, på AIxCC-scenen. Her er kjerneteamet vårt (8 kjernepersoner + ~3 leiesoldater):

Våre strategier veiledende prinsipper. TLDR bruker det beste verktøyet for jobben. Ikke forvent at LLM-er skal være magisk gode på ting vi vet at de ikke er.

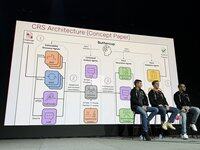

Det originale Buttercup-designet var vesentlig mer sofistikert. Den ble trimmet ned for å overholde reglene, og ta hensyn til ressursbegrensninger fra teamet vårt.

Vi gjorde det stort sett bra i semifinalen, og scoret mange førsteblodspoeng, men Java-feilsøkeren vår gikk i stykker og vi vet fortsatt ikke hvorfor!

Semifinalene validerte vår generelle tilnærming, men den trengte justering for å imøtekomme den massive økningen i skala for finalene. Vi kastet prototypen og startet fra bunnen av for finalen.

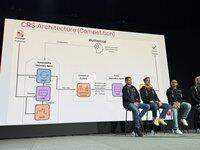

Henrik jobbet med orkestratoren: hvordan, hva og når du skal sende inn til konkurranse-API. Vi bestemte oss for å alltid kreve en PoV for å maksimere vår tillit til innsendingene.

Run fungerte med vår motor for oppdagelse av sårbarheter. Vi brukte standard oss-fuzz-fuzzere. Vi brukte et delt korpus der LLM-er hjalp fuzzere med å få dekning.

Ronald jobbet med vår motor for oppdagelse av sårbarheter. Vi brukte standard oss-fuzz-fuzzere. Vi brukte et delt korpus der LLM-er hjalp fuzzere med å få dekning.

Ronald jobbet med vår motor for oppdagelse av sårbarheter. Vi brukte standard oss-fuzz-fuzzere. Vi brukte et delt korpus der LLM-er hjalp fuzzere med å få dekning.

Patcheren er et multiagentsystem, 6k linjer med kode, LangChain/LangGraph, med ikke-resonnerende GPT-4.1. Sikkerhetsagent identifiserer rotårsaker, ingeniøragent finner testinstruksjoner, deretter QA-agent en oppdatering og validerer den. Hvis det mislykkes, justerer refleksjonsagenten strategien.

I Exhibition-runder scoret vi først i runde 1, krasjet hardt i 2 og spratt tilbake i 3. Vi var ressurseffektive i runde 1, og brukte bare $1k av et $30k LLM-budsjett. Runde 2 hadde vi en mindre skrivefeil som krasjet alt.

I den scorede runden fant vi mange feil med et begrenset budsjett (halvparten av tilgjengelig), med høy nøyaktighet, og scoret godt på tvers av alle oppgaver. Vi fant også minst 1 feil som ingen andre CRS gjorde, noe som viser at vi dekket nytt terreng.

Hvordan scoret vi så bra? Vi hadde 90 % nøyaktighet, scoret på tvers av alle oppgaver og laget oppdateringer av høy kvalitet for alle feilene våre.

Vi brukte den siste måneden på å lage en nedskalert versjon av smørblomst som kjører på den bærbare datamaskinen din. Vi har til hensikt å opprettholde den med en del av gevinstene. Det er åpen kildekode nå!

3,99K

Topp

Rangering

Favoritter