Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

.@trailofbits' Buttercup falando sobre nossa estratégia de competição agora, no palco AIxCC. Aqui está nossa equipe principal (8 pessoas principais + ~ 3 mercenários):

Nossas estratégias orientam princípios. TLDR use a melhor ferramenta para o trabalho. Não espere que os LLMs sejam magicamente bons em coisas que sabemos que não são.

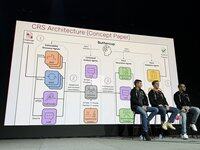

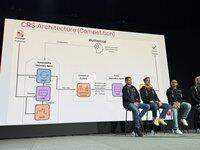

O design original do Buttercup era substancialmente mais sofisticado. Foi reduzido para cumprir as regras e levar em consideração as restrições de recursos de nossa equipe.

Nós nos saímos substancialmente bem nas semifinais, marcando muitos primeiros sangues, mas nosso localizador de bugs Java quebrou e ainda não sabemos por quê!

As semifinais validaram nossa abordagem geral, mas precisavam de ajustes para acomodar o aumento maciço na escala das finais. Jogamos o protótipo fora e começamos do zero para as finais.

Henrik trabalhou no orquestrador: como, o quê e quando enviar para a API de competição. Decidimos sempre exigir um PoV para maximizar nossa confiança nas submissões.

Run funcionou em nosso mecanismo de descoberta de vulnerabilidades. Usamos fuzzers oss-fuzz padrão. Usamos um corpus compartilhado onde os LLMs ajudaram os fuzzers a obter cobertura.

Ronald trabalhou em nosso mecanismo de descoberta de vulnerabilidades. Usamos fuzzers oss-fuzz padrão. Usamos um corpus compartilhado onde os LLMs ajudaram os fuzzers a obter cobertura.

Ronald trabalhou em nosso mecanismo de descoberta de vulnerabilidades. Usamos fuzzers oss-fuzz padrão. Usamos um corpus compartilhado onde os LLMs ajudaram os fuzzers a obter cobertura.

O patcher é um sistema multiagente, 6k linhas de código, LangChain/LangGraph, com GPT-4.1 sem raciocínio. O agente de segurança identifica as causas raiz, o agente de engenharia encontra instruções de teste e, em seguida, o agente de controle de qualidade é um patch e o valida. Se falhar, o agente de reflexão ajusta a estratégia.

Nas rodadas de exibição, marcamos primeiro na rodada 1, caímos forte na 2 e nos recuperamos na 3. Fomos eficientes em termos de recursos na rodada 1, usando apenas US$ 1 mil de um orçamento de US$ 30 mil do LLM. Na 2ª rodada, tivemos um pequeno erro de digitação que travou tudo.

Na rodada pontuada, encontramos muitos bugs com um orçamento limitado (metade do disponível), com alta precisão e pontuação boa em todas as tarefas. Também encontramos pelo menos 1 bug que nenhum outro CRS encontrou, mostrando que cobrimos um novo terreno.

Como pontuamos tão bem? Tivemos 90% de precisão, pontuamos em todas as tarefas e fizemos patches de alta qualidade para todos os nossos bugs.

Passamos o último mês fazendo uma versão reduzida do botão de ouro que roda no seu laptop. Pretendemos mantê-lo com uma parte dos ganhos. É de código aberto agora!

4K

Melhores

Classificação

Favoritos