Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

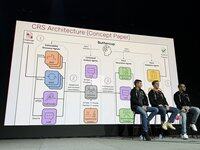

.@trailofbits' Buttercup-Team spricht jetzt auf der AIxCC-Bühne über unsere Wettbewerbsstrategie. Hier ist unser Kernteam (8 Kernmitglieder + ~3 Söldner):

Unsere Strategien und Leitprinzipien. TLDR: Verwenden Sie das beste Werkzeug für die Aufgabe. Erwarten Sie nicht, dass LLMs magisch gut in Dingen sind, von denen wir wissen, dass sie es nicht sind.

Das ursprüngliche Buttercup-Design war erheblich ausgefeilter. Es wurde reduziert, um den Regeln zu entsprechen und die Ressourcenbeschränkungen unseres Teams zu berücksichtigen.

Wir haben im Halbfinale erheblich gut abgeschnitten, viele First Bloods erzielt, aber unser Java-Bugfinder ist kaputt gegangen und wir wissen immer noch nicht, warum!

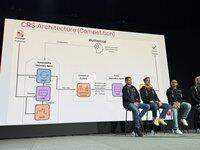

Die Halbfinals haben unseren Gesamtansatz validiert, aber er musste angepasst werden, um den massiven Anstieg der Skalierung für das Finale zu berücksichtigen. Wir haben den Prototypen verworfen und für das Finale von Grund auf neu begonnen.

Henrik arbeitete am Orchestrator: wie, was und wann man an die Wettbewerbs-API übermitteln sollte. Wir haben beschlossen, immer einen PoV zu verlangen, um unser Vertrauen in die Einreichungen zu maximieren.

Run arbeitete an unserer Schwachstellenerkennungs-Engine. Wir verwendeten Standard-OSS-Fuzz-Fuzzer. Wir verwendeten ein gemeinsames Corpus, bei dem LLMs den Fuzzern halfen, die Abdeckung zu erhöhen.

Ronald arbeitete an unserer Schwachstellenerkennungs-Engine. Wir verwendeten die Standard-OSS-Fuzz-Fuzzer. Wir nutzten ein gemeinsames Korpus, in dem LLMs den Fuzzern halfen, eine bessere Abdeckung zu erreichen.

Ronald arbeitete an unserer Schwachstellenerkennungs-Engine. Wir verwendeten die Standard-OSS-Fuzz-Fuzzer. Wir nutzten ein gemeinsames Korpus, in dem LLMs den Fuzzern halfen, eine bessere Abdeckung zu erreichen.

Der Patcher ist ein Multi-Agenten-System, 6.000 Zeilen Code, LangChain/LangGraph, mit nicht-argumentierendem GPT-4.1. Der Sicherheitsagent identifiziert die Ursachen, der Ingenieuragent findet Testanweisungen, dann erstellt der QA-Agent einen Patch und validiert ihn. Wenn er fehlschlägt, passt der Reflexionsagent die Strategie an.

In den Ausstellungsrunden haben wir in Runde 1 zuerst gepunktet, in Runde 2 hart abgestürzt und uns in Runde 3 zurückgekämpft. Wir waren in Runde 1 ressourcenschonend und haben nur 1.000 $ von einem 30.000 $ LLM-Budget verwendet. In Runde 2 hatten wir einen kleinen Tippfehler, der alles zum Absturz brachte.

In der bewerteten Runde haben wir viele Fehler mit einem begrenzten Budget (die Hälfte des verfügbaren Budgets) gefunden, mit hoher Genauigkeit, und haben in allen Aufgaben gut abgeschnitten. Wir haben auch mindestens einen Fehler gefunden, den kein anderer CRS entdeckt hat, was zeigt, dass wir Neuland betreten haben.

Wie haben wir so gut abgeschnitten? Wir hatten eine Genauigkeit von 90%, haben in allen Aufgaben Punkte erzielt und qualitativ hochwertige Patches für alle unsere Fehler erstellt.

Wir haben den letzten Monat damit verbracht, eine verkleinerte Version von Buttercup zu erstellen, die auf deinem Laptop läuft. Wir beabsichtigen, sie mit einem Teil der Gewinne zu warten. Sie ist jetzt Open Source!

3,99K

Top

Ranking

Favoriten