Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nous Research

Nous Research presents Hermes 4, our latest line of hybrid reasoning models.

Hermes 4 builds on our legacy of user-aligned models with expanded test-time compute capabilities.

Special attention was given to making the models creative and interesting to interact with, unencumbered by censorship, and neutrally aligned while maintaining state of the art level math, coding, and reasoning performance for open weight models.

10,74K

Nous Research a reposté

1/10🧵 @nousresearch a récemment publié une étude intéressante montrant que les modèles ouverts utilisent 2 à 3 fois plus de tokens que les modèles fermés pour les tâches de raisonnement.

Nous avons testé si l'allocation dynamique de tokens pouvait aider à combler cet écart d'efficacité. Voici ce que nous avons appris 👇

8,02K

Mesurer l'efficacité de la pensée dans les modèles de raisonnement : le benchmark manquant

Nous avons mesuré l'utilisation des tokens à travers les modèles de raisonnement : les modèles ouverts produisent 1,5 à 4 fois plus de tokens que les modèles fermés sur des tâches identiques, mais avec une énorme variance selon le type de tâche (jusqu'à 10 fois sur des questions simples).

Ce coût caché annule souvent les avantages de tarification par token. L'efficacité des tokens devrait devenir un objectif principal aux côtés des benchmarks de précision, surtout en tenant compte des cas d'utilisation non liés au raisonnement.

Lisez l'examen approfondi de l'efficacité du raisonnement à travers le paysage des modèles ouverts et fermés dans notre dernier article de blog en collaboration avec notre chercheur résident, Tim.

Découvrez plus de leurs travaux ici :

48,7K

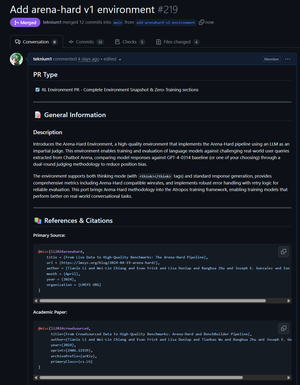

Nous Research a reposté

L'environnement d'évaluation Arena-Hard est maintenant fusionné avec Atropos - profitez d'une évaluation évolutive, flexible et moderne avec le benchmark arena-hard de @lmsysorg qui est très efficace pour déterminer un large éventail de capacités des modèles.

Prêt à être un environnement RL si vous apportez votre propre ensemble d'entraînement aussi :)

En savoir plus sur

6,95K

Notre chercheur en résidence @yaboilyrical discutera de son travail sur la direction SMC à UC Berkeley le 3 août.

Découvrez le blog sur ce travail ici :

Détails ci-dessous !

nightwing25 juil. 2025

je suis ravi d'annoncer que je serai intervenant au sommet DeAI de @BerkeleyRDI, présentant ma recherche avec @NousResearch sur le décodage de langage contraint !

si vous assistez au sommet, ou si vous souhaitez venir voir ma présentation, veuillez me contacter !

10,97K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables