Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nous Research

Nous Research presenta Hermes 4, nuestra última línea de modelos de razonamiento híbridos.

Hermes 4 se basa en nuestro legado de modelos alineados con el usuario, con capacidades de computación ampliadas en el tiempo de prueba.

Se prestó especial atención a hacer que los modelos sean creativos e interesantes para interactuar, sin estar limitados por la censura, y alineados de manera neutral mientras se mantiene un rendimiento de matemáticas, codificación y razonamiento de nivel de vanguardia para modelos de pesos abiertos.

10,69K

Nous Research republicó

1/10🧵 @nousresearch publicó recientemente un estudio interesante que muestra que los modelos abiertos utilizan de 2 a 3 veces más tokens que los modelos cerrados para tareas de razonamiento.

Probamos si la asignación dinámica de tokens podría ayudar a abordar esta brecha de eficiencia. Aquí está lo que aprendimos 👇

8,02K

Midiendo la Eficiencia del Pensamiento en Modelos de Razonamiento: El Benchmark Perdido

Medimos el uso de tokens en modelos de razonamiento: los modelos abiertos generan de 1.5 a 4 veces más tokens que los modelos cerrados en tareas idénticas, pero con una gran variabilidad dependiendo del tipo de tarea (hasta 10 veces en preguntas simples).

Este costo oculto a menudo anula las ventajas de precios por token. La eficiencia de tokens debería convertirse en un objetivo principal junto a los benchmarks de precisión, especialmente considerando los casos de uso no relacionados con el razonamiento.

Lee la revisión exhaustiva de la eficiencia de razonamiento en el panorama de modelos abiertos y cerrados en nuestra última publicación de blog en colaboración con nuestro investigador residente, Tim.

Ve más de su trabajo aquí:

48,66K

Nous Research republicó

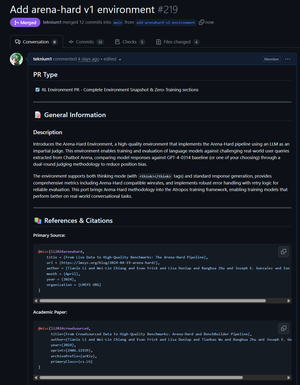

El entorno de evaluación Arena-Hard ahora se ha fusionado con Atropos: disfruta de una evaluación escalable, flexible y moderna con el benchmark arena-hard de @lmsysorg, que es excelente para determinar una amplia gama de capacidades en los modelos.

Listo para ser un entorno de RL si traes tu propio conjunto de entrenamiento también :)

Aprende más en

6,94K

Nuestro Investigador en Residencia @yaboilyrical estará discutiendo su trabajo sobre la dirección de SMC en UC Berkeley el 3 de agosto.

Consulta el blog sobre este trabajo aquí:

¡Detalles a continuación!

nightwing25 jul 2025

¡Emocionado de anunciar que seré ponente en la Cumbre DeAI de @BerkeleyRDI, presentando mi investigación con @NousResearch sobre la decodificación de lenguaje restringido!

Si vas a asistir a la cumbre, o quieres venir a ver mi charla, ¡por favor contáctame!

10,93K

Parte superior

Clasificación

Favoritos

En tendencia on-chain

En tendencia en X

Principales fondos recientes

Más destacado