Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Livello di esecuzione per operatori di intelligenza artificiale e robotica su @Solana

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

I VLA sono ancora molto nuovi e molte persone trovano difficile comprendere la differenza tra VLA e LLM.

Ecco un'analisi approfondita su come questi sistemi AI differiscono in ragionamento, percezione e azione. Parte 1.

Analizziamo le principali distinzioni e come gli agenti AI avvolti attorno a un LLM differiscano dagli agenti operativi che utilizzano modelli VLA:

1. Percezione: Come percepiscono il mondo

Agente (LLM): Elabora testo o dati strutturati, ad esempio JSON, API e a volte immagini. È come un cervello che lavora con input puliti e astratti. Pensa a leggere un manuale o analizzare un foglio di calcolo. Ottimo per ambienti strutturati ma limitato da ciò che gli viene fornito.

Operatore (VLA): Vede pixel grezzi e in tempo reale dalle telecamere, oltre ai dati dei sensori (ad es., tatto, posizione) e alla propriocezione (consapevolezza del movimento). È come navigare nel mondo con occhi e sensi, prosperando in ambienti dinamici e disordinati come interfacce utente o spazi fisici.

2. Azione: Come interagiscono

Agente: Agisce chiamando funzioni, strumenti o API. Immaginalo come un manager che invia istruzioni precise come "prenota un volo tramite l'API di Expedia." È deliberato ma si basa su strumenti predefiniti e interfacce chiare.

Operatore: Esegue azioni continue e a basso livello, come muovere un cursore del mouse, digitare o controllare le articolazioni di un robot. È come un lavoratore esperto che manipola direttamente l'ambiente, ideale per compiti che richiedono precisione in tempo reale.

3. Controllo: Come prendono decisioni

Agente: Segue un ciclo lento e riflessivo: pianifica, chiama uno strumento, valuta il risultato, ripete. È vincolato ai token (limitato dall'elaborazione del testo) e vincolato alla rete (in attesa delle risposte API). Questo lo rende metodico ma lento per compiti in tempo reale.

Operatore: Opera, prendendo decisioni passo dopo passo in un ciclo di feedback stretto. Pensa a un videogiocatore che reagisce istantaneamente a ciò che appare sullo schermo. Questa velocità consente un'interazione fluida ma richiede un'elaborazione robusta in tempo reale.

4. Dati per apprendere: Cosa alimenta il loro addestramento

Agente: Addestrato su vasti corpora di testo, istruzioni, documentazione o set di dati RAG (Generazione Aumentata da Recupero). Impara da libri, codice o FAQ, eccellendo nel ragionamento su conoscenze strutturate.

Operatore: Impara da dimostrazioni (ad es., video di umani che eseguono compiti), registri di teleoperazione o segnali di ricompensa. È come imparare guardando e praticando, perfetto per compiti in cui le istruzioni esplicite sono scarse.

5. Modi di fallimento: Dove si rompono

Agente: Incline all'allucinazione (inventare risposte) o a piani a lungo termine fragili che si rompono se un passo fallisce. È come un stratega che riflette troppo o interpreta male la situazione.

Operatore: Affronta il cambiamento di covariate (quando i dati di addestramento non corrispondono alle condizioni del mondo reale) o errori composti nel controllo (piccoli errori che si accumulano). È come un guidatore che perde il controllo su una strada sconosciuta.

6. Infrastruttura: La tecnologia dietro di loro

Agente: Si basa su un prompt/router per decidere quali strumenti chiamare, un registro degli strumenti per le funzioni disponibili e memoria/RAG per il contesto. È un setup modulare, come un centro di comando che orchestra i compiti.

Operatore: Ha bisogno di pipeline di ingestione video, un server di azione per il controllo in tempo reale, uno scudo di sicurezza per prevenire azioni dannose e un buffer di riproduzione per memorizzare le esperienze. È un sistema ad alte prestazioni costruito per ambienti dinamici.

7. Dove brillano: I loro punti di forza

Agente: Domina nei flussi di lavoro con API pulite (ad es., automazione dei processi aziendali), ragionamento su documenti (ad es., riassumere rapporti) o generazione di codice. È il tuo punto di riferimento per compiti strutturati e di alto livello.

Operatore: Eccelle in ambienti disordinati, privi di API, come navigare in interfacce utente ingombranti, controllare robot o affrontare compiti simili a giochi. Se comporta interazione in tempo reale con sistemi imprevedibili, il VLA è il re.

8. Modello mentale: Pianificatore + Esecutore

Pensa all'Agente LLM come al pianificatore: scompone compiti complessi in obiettivi chiari e logici.

L'Operatore VLA è l'esecutore, che realizza quegli obiettivi interagendo direttamente con pixel o sistemi fisici. Un controllore (un altro sistema o agente) monitora i risultati per garantire il successo.

$CODEC

18,3K

Codecflow Optr offre un approccio unificato per costruire agenti che vedono, ragionano e agiscono in ambienti digitali e fisici. Che si tratti di automatizzare flussi di lavoro su desktop, controllare bracci robotici o testare in simulazione, utilizza lo stesso modello mentale e le stesse primitive.

Louround 🥂21 ago, 04:10

I ribassi in un mercato rialzista devono essere acquistati, specialmente su progetti con grandi catalizzatori.

Sappiamo tutti che l'AI è la narrativa di questo ciclo, iniziata da ai16z e Virtuals lo scorso anno.

La mia scommessa è che il mercato si concentrerà su tecnologie più complesse e sofisticate come i VLA, e lasciami spiegarti perché.

I LLM (Modelli di Linguaggio di Grandi Dimensioni) leggono e scrivono principalmente testo: sono ottimi per spiegare, pianificare e generare istruzioni, ma non controllano di per sé motori o interagiscono con il mondo fisico (come potresti aver sperimentato con chatgpt).

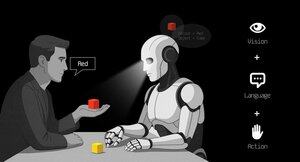

I VLA (Modelli di Visione Linguaggio Azione) si differenziano dagli LLM in quanto sono sistemi multimodali che osservano le cose (visione), comprendono istruzioni (linguaggio) e producono direttamente azioni. È come dire a un robot di prendere una tazza rossa e poi muovere il suo braccio per farlo.

I VLA sono addestrati su esempi che abbinano immagini/video + istruzioni + tracce di azione reali (come un robot si è effettivamente mosso), e devono funzionare rapidamente e in sicurezza in tempo reale. Gli LLM, dal canto loro, sono addestrati su enormi collezioni di testo e si concentrano su ragionamento e compiti linguistici.

TL;DR: Gli LLM pensano e parlano mentre i VLA vedono, ragionano e agiscono.

Come puoi vedere, i VLA sono un'aggiunta importante agli LLM e abiliteranno notevolmente la prossima innovazione da 0 a 1 nell'economia complessiva che sarà la robotica. La maggior parte dei fondi di investimento sta allocando una grande parte dei loro investimenti in questo settore, visto come la prossima evoluzione logica nell'industria dell'AI.

Ho già fatto un post tempo fa sul leader attuale nel mercato delle criptovalute, @codecopenflow, che non ha raccolto capitali (lancio equo) ma sta già spedendo prodotti all'avanguardia e attualmente ha un FDV di $23M.

Per informazione, altri concorrenti crypto hanno raccolto $20m ( @openmind_agi) a quello che probabilmente è un FDV di $200M a $300M ++ mentre nessun prodotto o comunità è stata costruita e spedita finora.

Ciò che rende Codec un progetto leader nel settore è che affrontano un collo di bottiglia cruciale nella robotica e nell'AI, che è la difficoltà di far interagire tutti gli strumenti AI insieme. Lasciami spiegare.

Il loro ultimo rilascio, OPTR (operatore), è un toolkit che aiuta a costruire operatori capaci di interagire su più piattaforme come robot, desktop, browser o simulazioni. L'obiettivo di un operatore è vedere, ragionare e agire (VLA) sia nei mondi digitali (computer) che fisici (robot).

Questo toolkit funge da infrastruttura fondamentale per i team robotici che mirano a testare il loro prodotto e migliorare l'intero processo fornendo un'esperienza unificata invece di esperienze separate per browser web, simulazioni o robot. Questo rende essenzialmente l'operatore adattivo e autonomo indipendentemente dal suo ambiente.

Quindi capisci, farà risparmiare molto tempo alle aziende e agli sviluppatori che in precedenza dovevano seguire ogni passaggio manualmente e dove puoi risparmiare tempo puoi risparmiare denaro.

Consentirà anche a Codec di costruire i propri progetti di operatori e lanciare nuove capacità relativamente rapidamente sul mercato, in particolare attraverso il loro marketplace.

TL;DR: Probabilmente hai visto video di robot che piegano fazzoletti, ordinano scatole o saltano su vari elementi. Sono stati tutti addestrati per questo caso d'uso molto specifico, e sfortunatamente, una competenza non può essere riutilizzata in un altro ambiente come potrebbe fare un umano. OPTR di Codec risolve questo rendendo le competenze trasferibili tra ambienti e situazioni, rendendo l'addestramento e lo sviluppo molto più veloci e meno costosi per le imprese.

Ecco perché Codec è così interessante nell'unificare il mondo digitale con il mondo fisico.

$CODEC, Coded.

2,26K

La società di ricerca @epochbiz (di @ZoomerOracle) ha pubblicato un dettagliato studio su CodecFlow.

Non perdertelo.

$CODEC

epoch_19 ago, 21:07

$CODEC si sta preparando per essere la migliore opzione come gioco onchain per la Robotica

L'articolo di ricerca su @codecopenflow è ora disponibile su 🤖

3,53K

Stiamo assistendo a un aumento degli account falsi che affermano di rappresentare CodecFlow.

Gli unici X/Twitter ufficiali sono @codecopenflow e @RoboMove.

Tutti gli altri canali verificati sono elencati sul nostro sito web.

C'è solo un token, $CODEC.

Rimani vigile e segnala eventuali account sospetti.

Si prega di ripubblicare e condividere per aiutare a diffondere la parola.

3,23K

RoboMove è una vetrina alimentata interamente dall'infrastruttura di CodecFlow.

Non esiste un token separato. $CODEC è l'unico token all'interno dell'ecosistema.

@RoboMove è solo un esempio di ciò che è possibile fare con i CodecFlow Operators.

Presto, gli sviluppatori potranno costruire i propri sistemi avanzati su CodecFlow utilizzando il nostro SDK e gli strumenti.

La piattaforma è intenzionalmente aperta ed estensibile, consentendo casi d'uso infiniti, dal controllo robotico all'automazione GUI.

⚠️ Non cadere in trappola con token falsi o imitatori. Verifica sempre da fonti ufficiali.

3,74K

Siamo felici di vedere la comunità cinese notare CodecFlow e amare ciò che stiamo costruendo.

欢迎你们. Stiamo appena iniziando. Molto altro arriverà.

0xFunky13 lug 2025

PUMP la vendita pubblica è finita, inizialmente avevo investito molto su Bybit, lasciando solo 1/2 sulla catena, alla fine solo quello sulla catena ha avuto successo, per fortuna non ho coperto in anticipo...

A proposito, recentemente nella comunità AI molte persone stanno discutendo di VLA (Vision‑Language‑Action)

Ho fatto una ricerca sui progetti sulla catena per vedere se qualcuno stava lavorando su VLA, e ho visto questo progetto CodecFlow @Codecopenflow, ho comprato un po'.

== Cosa fa il progetto CodecFlow ==

Una breve introduzione a VLA, VLA è un'architettura di modello che consente all'AI non solo di "parlare", ma anche di "fare".

I tradizionali LLM (come GPT) possono solo comprendere il linguaggio e fornire suggerimenti, ma non possono eseguire azioni, non possono cliccare sullo schermo, non possono afferrare oggetti.

Il modello VLA significa integrare tre grandi capacità:

1. Visione: comprendere immagini, screenshot, input della fotocamera o dati dei sensori

2. Linguaggio: comprendere i comandi in linguaggio naturale degli esseri umani

3. Azione: generare comandi eseguibili, come clic del mouse, input da tastiera, controllo di bracci meccanici

CodecFlow sta lavorando su VLA sulla catena, tutti i processi operativi possono essere registrati sulla catena, auditabili, verificabili e liquidabili.

In breve, è l'infrastruttura di base per un "robot AI".

== Perché ho prestato particolare attenzione a questo progetto? ==

Ho scoperto che i loro sviluppatori sono i principali contributori del progetto open source LeRobot, il più popolare nel campo VLA!

LeRobot è la base di alto livello per costruire modelli VLA nel mondo open source, inclusi SmolVLA e altri modelli leggeri che possono funzionare su laptop.

Questo significa che questo team comprende davvero l'architettura VLA e i robot.

Ho visto che continuano a costruire, il prezzo della moneta è anche stabilmente in aumento, io stesso sono molto ottimista sul settore VLA, e guardando la tendenza generale, VLA e i robot sono sicuramente il futuro nel mercato.

• I giganti del Web2 (Google, Meta, Tesla) si sono attualmente impegnati a fondo nella formazione di VLA e robot;

• Ci sono pochi progetti Web3 che possono eseguire applicazioni VLA, e sono molto rari

• VLA ha l'opportunità di esprimere un enorme valore in scenari come DePIN, automazione web, esecuzione di agenti AI sulla catena.

CA: 69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Fai sempre le tue ricerche.

3,99K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari