Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

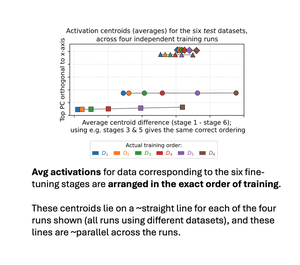

1/ Новая статья — *недавность порядка обучения линейно закодирована в активациях LLM*! Мы последовательно дообучали модель на 6 наборах данных с разными сущностями. Средние активации 6 соответствующих тестовых наборов выстраиваются в точном порядке обучения! И линии для разных запусков обучения ~параллельны!

Топ

Рейтинг

Избранное