Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

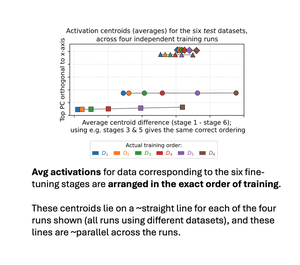

1/ Novo artigo — *a recência da ordem de treinamento é codificada linearmente nas ativações do LLM*! Ajustamos sequencialmente um modelo em 6 conjuntos de dados com entidades disjuntas. As ativações médias dos 6 conjuntos de teste correspondentes se alinham na ordem exata de treinamento! E as linhas para corridas de treinamento de diferenças são ~paralelas!

Melhores

Classificação

Favoritos