Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

elvis

Construindo com agentes de IA @dair_ai • Anterior: Meta AI, Galactica LLM, Elastic, PaperswithCode, PhD • Compartilho insights sobre como construir com LLMs & AI Agents ⬇️

Como aplicar engenharia de contexto eficaz para agentes de IA?

Leia isto se você é um desenvolvedor de IA construindo agentes de IA hoje.

O contexto é rei! E deve ser engenheirado, não apenas solicitado.

Escrevi algumas notas após ler o incrível novo guia de engenharia de contexto da Anthropic:

Engenharia de Contexto vs. Engenharia de Prompt

- Engenharia de Prompt = escrever e organizar instruções

- Engenharia de Contexto = curar e manter prompts, ferramentas, histórico,

e dados externos

- A Engenharia de Contexto é iterativa, e o contexto é curado regularmente

Por que a Engenharia de Contexto é Importante?

- Orçamento de atenção finito

- A degradação do contexto ocorre se o contexto se torna muito grande; a engenharia de contexto ajuda

- Objetivo: curar e manter tokens de alto sinal mínimos

Anatomia de um Contexto Eficaz

- Prompts do sistema: claros, na altitude certa (não muito específicos ou muito vagos)

- Ferramentas: mantenha as ferramentas mínimas, use parâmetros descritivos e busque

eficácia em tokens

- Exemplos de Few-Shot: forneça exemplos diversos e canônicos do comportamento desejado

- Histórico de mensagens: faça uma poda agressiva

Estratégias de Recuperação de Contexto

- Pré-recuperação vs. just-in-time; há uma mudança em direção à busca agente

- Use referências leves (caminhos de arquivos, consultas armazenadas) para carregar dinamicamente

contexto em tempo de execução

- Habilite a descoberta incremental de contexto relevante por meio da exploração

- Estratégia de busca híbrida: pré-carregar + recuperar dinamicamente

Engenharia de Contexto para Tarefas de Longo Prazo

- Compactação: resumir e redefinir o contexto à medida que as subtarefas são concluídas

- Tomada de Notas Estruturada: use memória externa persistente (registros, tarefas a fazer)

- Sub-agentes: o orquestrador coordena/plano, e os sub-agentes realizam tarefas com suas próprias janelas de contexto que são então resumidas

Acredito que estas são as bases para construir pipelines de contexto escaláveis e confiáveis para agentes de IA. Mas há muito mais nisso. Tenho certeza de que mais estratégias eficazes surgirão com o tempo.

48,05K

Como treinar modelos de raciocínio pequenos de forma mais eficaz?

Este é um problema com o qual muitos desenvolvedores de IA se deparam. O ajuste fino por RL, em geral, tende a estagnar, especialmente para modelos de 1 a 2 bilhões.

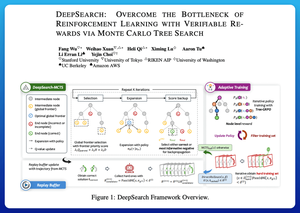

Acho que o DeepSearch oferece uma abordagem realmente limpa aqui. Ele pega a ideia da Busca em Árvore de Monte Carlo (MCTS) na inferência e a move para o loop de treinamento. Essa mudança desbloqueia uma melhor exploração e um aprendizado mais eficiente.

Aqui estão minhas anotações do artigo:

O loop envolve quatro ideias principais:

Busca Durante o Treinamento: Em vez de fazer busca apenas no momento do teste, o MCTS é executado durante o treinamento de RL. Um seletor UCT local classifica os irmãos, enquanto um avaliador de fronteira global escolhe folhas promissoras em toda a árvore com base no valor do pai, entropia e profundidade.

Aprendendo com Vitórias e Erros Confiantes: Se uma solução correta não for encontrada, o modelo ainda aprende supervisionando o caminho errado confiante (erros de menor entropia). Caminhos corretos permanecem não negativos durante as atualizações, o que ajuda na atribuição de crédito a nível de passo.

Estabilizando o RL com Tree-GRPO: Eles refinam objetivos estilo PPO com valores q a nível de nó, normalização apenas da média e uma estratégia de clipping suave. Isso evita explosões de recompensa enquanto mantém os gradientes informativos.

Mantendo a Eficiência: Para cortar o desperdício de computação, o DeepSearch filtra para um subconjunto restrito de problemas, armazena soluções uma vez que são verificadas e pula a busca completa quando uma resposta já é conhecida.

Todas essas melhorias levam a resultados fortes.

O DeepSearch-1.5B alcança 62,95% nos benchmarks AIME/AMC, superando uma linha de base Nemotron de topo enquanto usa apenas ~330 horas de GPU. Em comparação, o treinamento normal de RL estagna mais baixo mesmo com mais de 1.800 horas de GPU.

Artigo:

Acho que este artigo oferece uma receita prática para superar platôs em LMs de raciocínio pequenos:

• Mover a busca para o treinamento, não apenas para a inferência

• Supervisionar tanto caminhos corretos quanto errados

• Usar priorização global para explorar de forma mais inteligente

• Armazenar em cache e filtrar para manter a eficiência alta

26,87K

Top

Classificação

Favoritos