Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hoe train je kleine redeneermodellen effectiever?

Dit is een probleem waar veel AI-ontwikkelaars tegenaan lopen. RL-fijnstelling heeft over het algemeen de neiging om te stabiliseren, vooral voor modellen van 1–2B.

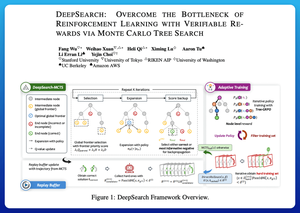

Ik denk dat DeepSearch hier een echt schone aanpak biedt. Het neemt het idee van Monte Carlo Tree Search (MCTS) tijdens inferentie en verplaatst het naar de trainingslus. Die verschuiving ontgrendelt betere verkenning en efficiënter leren.

Hier zijn mijn aantekeningen uit het paper:

De lus omvat vier belangrijke ideeën:

Zoeken Tijdens Training: In plaats van alleen zoeken tijdens de testfase, wordt MCTS uitgevoerd tijdens RL-training. Een lokale UCT-selector rangschikt broers en zussen, terwijl een globale frontier-scorer veelbelovende bladeren over de hele boom selecteert op basis van ouderwaarde, entropie en diepte.

Leren Van Zowel Overwinningen Als Zeker Foute Antwoorden: Als er geen correcte oplossing wordt gevonden, leert het model nog steeds door de zelfverzekerde foute weg (laagste entropiefouten) te superviseren. Correcte paden blijven niet-negatief tijdens updates, wat helpt bij de toewijzing van krediet op stap-niveau.

Stabiliseren van RL met Tree-GRPO: Ze verfijnen PPO-stijl doelstellingen met knooppunt-niveau q-waarden, alleen gemiddelde normalisatie en een zachte clippingstrategie. Dit voorkomt beloningsexplosies terwijl de gradiënten informatief blijven.

Efficiënt Blijven: Om verspilde rekencapaciteit te verminderen, filtert DeepSearch naar een harde subset van problemen, cachet oplossingen zodra ze zijn geverifieerd en slaat volledige zoekopdrachten over wanneer een antwoord al bekend is.

Al deze verbeteringen leiden tot sterke resultaten.

DeepSearch-1.5B bereikt 62,95% op AIME/AMC benchmarks, wat een top Nemotron-basislijn overtreft terwijl het slechts ~330 GPU-uren gebruikt. Ter vergelijking, normale RL-training stabiliseert lager, zelfs met 1.800+ GPU-uren.

Paper:

Ik denk dat dit paper een praktische recept biedt om door plateaus in kleine redeneer-LM's heen te breken:

• Verplaats zoeken naar training, niet alleen inferentie

• Superviseer zowel juiste als foute paden

• Gebruik globale prioritering om slimmer te verkennen

• Cache en filter om de efficiëntie hoog te houden

Boven

Positie

Favorieten