المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

كيف تدرب نماذج التفكير الصغيرة بشكل أكثر فعالية؟

هذه مشكلة يواجهها العديد من مطوري الذكاء الاصطناعي. يميل الضبط الدقيق ل RL ، بشكل عام ، إلى الاستقرار ، خاصة بالنسبة لطرازات 1-2B.

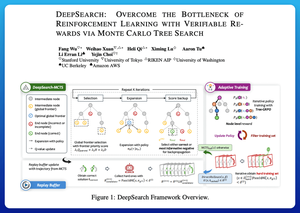

أعتقد أن DeepSearch يقدم نهجا نظيفا حقا هنا. يأخذ فكرة بحث شجرة مونت كارلو (MCTS) عند الاستدلال وينقلها إلى حلقة التدريب. هذا التحول يفتح استكشافا أفضل وتعليما أكثر كفاءة.

فيما يلي ملاحظاتي من الورقة:

تتضمن الحلقة أربع أفكار رئيسية:

البحث أثناء التدريب: بدلا من إجراء البحث فقط في وقت الاختبار ، يتم تشغيل MCTS أثناء تدريب RL. يصنف محدد UCT المحلي الأشقاء ، بينما يختار هداف الحدود العالمية أوراقا واعدة عبر الشجرة بأكملها بناء على القيمة الأصلية والإنتروبيا والعمق.

التعلم من كل من الانتصارات والأخطاء الواثقة: إذا لم يتم العثور على حل صحيح ، فإن النموذج لا يزال يتعلم من خلال الإشراف على المسار الخاطئ الواثق (أقل أخطاء الانتروبيا). تظل المسارات الصحيحة غير سالبة أثناء التحديثات، مما يساعد في تعيين الرصيد على مستوى الخطوات.

تثبيت RL باستخدام Tree-GRPO: يقومون بتحسين الأهداف على غرار PPO بقيم q على مستوى العقدة ، وتطبيع المتوسط فقط ، واستراتيجية القطع الناعمة. هذا يتجنب انفجارات المكافأة مع الحفاظ على التدرجات مفيدة.

الحفاظ على الكفاءة: لتقليل الحوسبة الضائعة ، يقوم DeepSearch بتصفية مجموعة فرعية صلبة من المشكلات ، وتخزين الحلول مؤقتا بمجرد التحقق منها ، وتخطي البحث الكامل عندما تكون الإجابة معروفة بالفعل.

كل هذه التحسينات تؤدي إلى نتائج قوية.

يصل DeepSearch-1.5B إلى 62.95٪ على معايير AIME / AMC ، متفوقا على خط أساس Nemotron الأعلى أثناء استخدام ~ 330 ساعة GPU فقط. وبالمقارنة ، فإن هضاب تدريب RL العادية تنخفض حتى مع 1,800+ ساعة GPU.

ورق:

أعتقد أن هذه الورقة تقدم وصفة عملية لاختراق الهضاب في LMs المنطقية الصغيرة:

• نقل البحث إلى التدريب ، وليس فقط الاستدلال

• الإشراف على المسارات الصحيحة والخاطئة

• استخدام تحديد الأولويات العالمية لاستكشاف أكثر ذكاء

• ذاكرة التخزين المؤقت والفلتر للحفاظ على الكفاءة العالية

الأفضل

المُتصدِّرة

التطبيقات المفضلة