Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Theodor Marcu

Leder for produktvekst @cognition

Du har kanskje sett den MIT-studien om hvordan 95 % av AI-pilotene mislykkes, men etter å ha snakket med @sumanyu_sharma, tror jeg at det mesteparten av tiden bare er et ferdighetsproblem.

De fleste presser ikke AI-verktøy hardt nok, så de gir raskt opp. Men når du snakker med folk som kjenner til det (som AI-innfødte startups), er det helt overveldende hvor mye mer du kan gjøre i dag sammenlignet med for noen år siden hvis du utvikler den rette intuisjonen om hvordan du skal jobbe med AI.

Nettet av det er at "AI-feil" i stor grad er et distribusjonsproblem, ikke et teknologiproblem. Lagene som vinner vil være de som utvikler muskelminnet for å jobbe med disse systemene i stor skala.

Cognition22. aug., 03:44

Devin skriver 25 % av det totale kodevolumet på @HammingAI.

Vi satte oss ned med Hamming-gründer @sumanyu_sharma for å snakke om deres tilnærming til å gjøre oppgaver "avveielige":

12,31K

Hvis du fortalte meg det

Jeg kunne komme på jobb

Skriv en haug med billetter

og har alt arbeidet mitt avgrenset + omgjort til PR-er innen lunsj

Jeg ville betalt deg penger personlig

men det er mulig nå som en del av Devin

Cognition20. aug., 00:59

Vi leverte store oppgraderinger til Devins @linear integrasjon!

💵 Og billettomfang er nå gratis for alle lineære billetter frem til slutten av året, hvis du begynner å jobbe med Devin før 30.

Hva vi bygde 👇

533

Hvis du fortalte meg det

Jeg kunne komme på jobb

Skriv en haug med billetter

og har alt arbeidet mitt avgrenset + omgjort til PR-er innen lunsj

Jeg vil kalle BS på deg

Cognition20. aug., 00:59

Vi leverte store oppgraderinger til Devins @linear integrasjon!

💵 Og billettomfang er nå gratis for alle lineære billetter frem til slutten av året, hvis du begynner å jobbe med Devin før 30.

Hva vi bygde 👇

373

Jeg er så stolt av alle som jobbet med Wave 12 - mye arbeid har gått med til å sende denne utgivelsen

Jeg personlig er veldig spent på hvordan vi bringer så mange ideer fra Devin inn i Windsurf

DeepWiki + Agentendringer + Vibe og Replace er bare det første trinnet

Windsurf15. aug., 03:22

Wave 12 is here, and it’s a big one!

📚 DeepWiki-powered docs for every symbol in your codebase

🔍 Vibe and Replace

🐛 100+ bugs squashed

🎨 Brand new UI

… and more!

Everything that’s new 🧵

6,25K

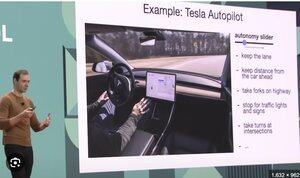

Autonomi-glidebrytere overalt

Andrej Karpathy10. aug., 00:53

Jeg legger merke til at på grunn av (tror jeg?) mye benchmarkmaxxing på langsiktige oppgaver, blir LLM-er litt for agentiske som standard, litt over mitt gjennomsnittlige brukstilfelle.

For eksempel i koding har modellene nå en tendens til å resonnere i ganske lang tid, de har en tilbøyelighet til å begynne å liste opp og gripe filer over hele repoen, de gjør gjentatte nettsøk, de overanalyserer og overtenker små sjeldne kanttilfeller selv i kode som er bevisst ufullstendig og under aktiv utvikling, og kommer ofte tilbake ~minutter senere selv for enkle spørringer.

Dette kan være fornuftig for langvarige oppgaver, men det passer mindre godt for mer "in the loop" iterert utvikling som jeg fortsatt gjør mye av, eller hvis jeg bare leter etter en rask stikkprøve før jeg kjører et skript, i tilfelle jeg fikk feil indeksering eller gjorde en dum feil. Så jeg tar meg selv ganske ofte i å stoppe LLM-ene med variasjoner av "Stopp, du overtenker dette. Se bare på denne ene filen. Ikke bruk verktøy. Ikke overkonstruer" osv.

I utgangspunktet når standarden sakte begynner å snike seg inn i "ultrathink" superagentisk modus, føler jeg et behov for det motsatte, og mer generelt gode måter å indikere eller kommunisere intensjoner / innsatser på, fra "bare ta en rask titt" hele veien til "gå av i 30 minutter, kom tilbake når du er helt sikker".

495

Theodor Marcu lagt ut på nytt

Jeg legger merke til at på grunn av (tror jeg?) mye benchmarkmaxxing på langsiktige oppgaver, blir LLM-er litt for agentiske som standard, litt over mitt gjennomsnittlige brukstilfelle.

For eksempel i koding har modellene nå en tendens til å resonnere i ganske lang tid, de har en tilbøyelighet til å begynne å liste opp og gripe filer over hele repoen, de gjør gjentatte nettsøk, de overanalyserer og overtenker små sjeldne kanttilfeller selv i kode som er bevisst ufullstendig og under aktiv utvikling, og kommer ofte tilbake ~minutter senere selv for enkle spørringer.

Dette kan være fornuftig for langvarige oppgaver, men det passer mindre godt for mer "in the loop" iterert utvikling som jeg fortsatt gjør mye av, eller hvis jeg bare leter etter en rask stikkprøve før jeg kjører et skript, i tilfelle jeg fikk feil indeksering eller gjorde en dum feil. Så jeg tar meg selv ganske ofte i å stoppe LLM-ene med variasjoner av "Stopp, du overtenker dette. Se bare på denne ene filen. Ikke bruk verktøy. Ikke overkonstruer" osv.

I utgangspunktet når standarden sakte begynner å snike seg inn i "ultrathink" superagentisk modus, føler jeg et behov for det motsatte, og mer generelt gode måter å indikere eller kommunisere intensjoner / innsatser på, fra "bare ta en rask titt" hele veien til "gå av i 30 minutter, kom tilbake når du er helt sikker".

129,41K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til