Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

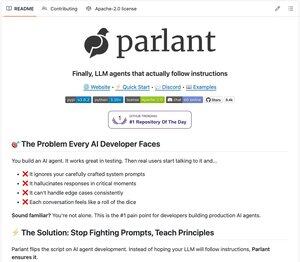

I prompt di sistema stanno diventando obsoleti!

Ecco una lezione controintuitiva dall'esperienza nella costruzione di Agenti nel mondo reale:

Scrivere enormi prompt di sistema non migliora le prestazioni di un Agente; spesso le peggiora.

Ad esempio, aggiungi una regola sulle politiche di rimborso. Poi una sul tono. Poi un'altra su quando escalare. Prima di rendertene conto, hai un manuale di istruzioni di 2.000 parole.

Ma ecco cosa abbiamo imparato: i LLM sono estremamente scarsi nel gestire questo.

Ricerche recenti confermano anche ciò che molti di noi sperimentano. C'è una "Maledizione delle Istruzioni". Più regole aggiungi a un prompt, peggiore sarà la prestazione del modello nel seguire una singola regola.

Ecco un approccio migliore: linee guida condizionali contestuali.

Invece di un unico grande prompt, suddividi le tue istruzioni in pezzi modulari che vengono caricati nel LLM solo quando sono rilevanti.

```

agent.create_guideline(

condition="Il cliente chiede informazioni sui rimborsi",

action="Controlla prima lo stato dell'ordine per vedere se è idoneo",

tools=[check_order_status],

)

```

Ogni linea guida ha due parti:

- Condizione: Quando viene caricata?

- Azione: Cosa dovrebbe fare l'agente?

La magia avviene dietro le quinte. Quando arriva una query, il sistema valuta quali linee guida sono rilevanti per lo stato attuale della conversazione.

...

Principali

Ranking

Preferiti