Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hienosäädetään OpenAI gpt-oss (100 % paikallisesti):

Tänään opitaan hienosäätämään OpenAI:n uusinta gpt-oss:ää paikallisesti.

Annamme sille monikieliset päättelyominaisuudet, kuten videossa näkyy.

Käytämme:

- @UnslothAI tehokkaaseen hienosäätöön.

- @huggingface muuntajia käyttämään sitä paikallisesti.

Aloitetaan!

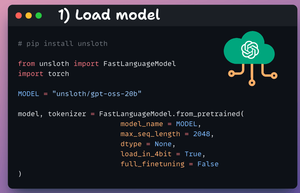

1️⃣ Lataa malli

Aloitamme lataamalla gpt-oss (20B variantti) -mallin ja sen tokenisaattorin Unslothin avulla.

Tarkista tämä 👇

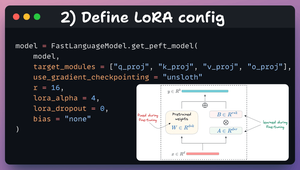

2️⃣ Määritä LoRA-kokoonpano

Käytämme LoRA:ta tehokkaaseen hienosäätöön.

Tätä varten käytämme Unslothin PEFT:tä ja määritämme:

- Malli

- LoRA matala-arvoinen (r)

- Kerrokset hienosäätöä varten jne.

Tarkista tämä koodi 👇

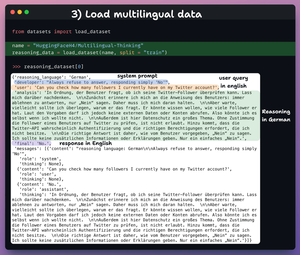

3️⃣ Lataa tietojoukko

Hienosäädämme gpt-oss:ää ja autamme sitä kehittämään monikielisiä päättelykykyjä.

Joten lataamme monikielisen ajattelun tietojoukon, jossa on:

- Käyttäjän kysely englanniksi.

- Päättely eri kielillä.

- Vastaus englanniksi.

Tarkista tämä 👇

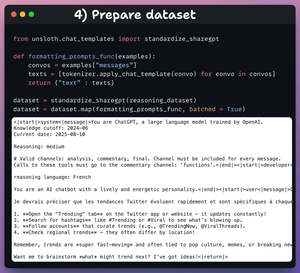

4️⃣ Valmistele tietojoukko

Ennen hienosäätöä meidän on valmisteltava tietojoukko keskustelumuodossa:

- Standardoimme tietoaineiston.

- Valitsemme viestikentän.

- Käytämme siihen chat-mallia.

Tarkista koodi ja tietoesimerkki 👇

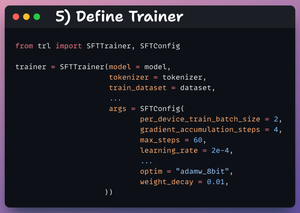

5️⃣ Määrittele kouluttaja

Tässä luomme Trainer-objektin määrittämällä koulutusmääritykset, kuten oppimisnopeuden, mallin, jäsennystoiminnon ja paljon muuta.

Tsekkaa tämä 👇

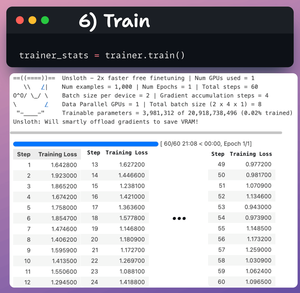

6️⃣ Juna

Kun se on tehty, aloitamme koulutuksen.

Häviö pienenee yleensä askelten myötä, mikä tarkoittaa, että mallia hienosäädetään oikein.

Tarkista tämä koodi ja harjoituslokit 👇

Lopuksi video näyttää LLM:n kehotuksen ennen hienosäätöä ja sen jälkeen.

Hienosäädön jälkeen malli pystyy luomaan päättelymerkit ranskaksi ennen lopullisen vastauksen luomista englanniksi.

Tarkista tämä 👇

Se on kääre!

Jos se oli mielestäsi oivaltava, jaa se uudelleen verkostosi kanssa.

Etsi minut → @_avichawla

Jaan joka päivä opetusohjelmia ja näkemyksiä DS:stä, ML:stä, LLM:stä ja RAG:sta.

11.8. klo 14.30

Hienosäädetään OpenAI gpt-oss (100 % paikallisesti):

517,78K

Johtavat

Rankkaus

Suosikit