Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

¿Por qué no entrenamos previamente los modelos para tareas agenciales?

bueno, estos muchachos lo hicieron. Y funcionó.

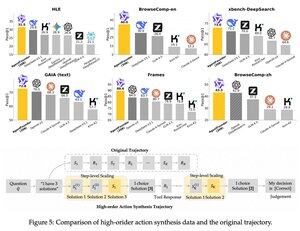

introdujeron un paso intermedio después del entrenamiento previo y antes del entrenamiento posterior. sintetizaron los datos de acción de los agentes y su modelo AgentFounder-30B establece el nuevo SOTA en 10 puntos de referencia.

SFT también tiene una pérdida significativamente menor después de este paso de preentrenamiento continuo agéntico.

¿Por qué funciona esto?

Debido a que los modelos fundacionales de propósito general generalmente no tienen sesgo inductivo agente, lo que pone a Burdon en el entrenamiento posterior.

Cuando se introduce el razonamiento de varios pasos y el uso de herramientas en la etapa previa al entrenamiento, se facilita el camino para el postentrenamiento, especialmente cuando se hace con una combinación de tareas agenciales de corto y largo horizonte.

Entonces, ¿qué significa esto si administra su negocio con agentes o los construye a cualquier escala?

Puede sintetizar datos a bajo costo, entrenar previamente un modelo fundamental y luego entrenarlo posteriormente.

Populares

Ranking

Favoritas