Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Warum trainieren wir keine Modelle für agentische Aufgaben vor?

Nun, diese Leute haben es getan. Und es hat funktioniert.

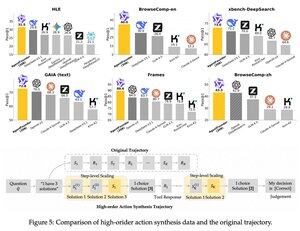

Sie führten einen Zwischenschritt nach dem Vortraining und vor dem Nachtraining ein. Sie synthetisierten Daten zu agentischen Aktionen und ihr AgentFounder-30B-Modell setzt neue SOTA auf 10 Benchmarks.

SFT hat auch nach diesem agentischen kontinuierlichen Vortraining-Schritt signifikant kleinere Verluste.

Warum funktioniert das?

Weil allgemeine grundlegende Modelle normalerweise keinen agentischen induktiven Bias haben, was die Last auf das Nachtraining legt.

Wenn Sie mehrstufiges Denken und Werkzeugnutzung in der Vortrainingsphase einführen, erleichtern Sie den Weg für das Nachtraining, insbesondere wenn Sie es mit einer Mischung aus kurzen und langen agentischen Aufgaben tun.

Was bedeutet das also, wenn Sie Ihr Geschäft mit Agenten betreiben oder sie in irgendeinem Maßstab aufbauen?

Sie können Daten kostengünstig synthetisieren, ein grundlegendes Modell weiter vortrainieren und es dann nachtrainieren.

Top

Ranking

Favoriten