Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Es ist immer schön zu sehen, dass mehr Arbeit in die Erweiterung von diloco gesteckt wird und die Bandbreitenanforderungen für das Pretraining reduziert werden!

22. Aug. 2025

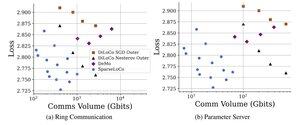

Einführung von SparseLoCo: eine kommunikationseffiziente Methode für das Pre-Training von LLM.

TL;DR: Wir nutzen Top-k-Sparsifikation + Fehlerfeedback mit den seltenen äußeren Schritten von DiLoCo – kommunizieren nur 1–3% der Gradienten mit 2-Bit-Quantisierung – und übertreffen DiLoCo und DeMo. 1/N,

ArXiv:

Github:

4,97K

Top

Ranking

Favoriten